Aufbau und Ausbildung eines Cyber Crisis Management Teams

Können wir uns mittels gezielten Trainings auf zukünftige Cyber-Security-Vorfälle vorbereiten, sodass wir im Ernstfall möglichst keine Zeit verlieren und die richtigen Entscheide treffen? Diesen Fragen sind wir im Blogbeitrag vom 23. August 2023 nachgegangen. Im ersten Teil der Blogserie wurde über das Trainieren von Cyber-Security-Vorfällen aufgezeigt, warum Trainings unerlässlich sind, welche Voraussetzungen diese benötigen, welche Varianten von Trainings existieren und welche Rollen explizit trainiert werden sollen. Im zweiten Teil der Serie möchten wir der Frage nachgehen, weshalb man ein Cyber Crisis Management Team benötigt und wie ein solches Team aufgebaut, ausgebildet und trainiert wird.

Warum benötigen wir ein Cyber Crisis Management Team

Im ersten Blogbeitrag dieser Blogserie wurde erwähnt, dass für den Incident-Response-Prozess ein Major Security Incident Management bzw. ein Cyber Crisis Management Team (dieser Begriff wird nachfolgend verwendet) benötigt wird. In einem ersten Schritt wollen wir der Frage nachgehen, wieso es überhaupt ein solches Team erforderlich ist.

Cyber Security Incidents werden in der Regel in zwei Kategorien eingeteilt: in «Minor Security Incidents» (kleinere Sicherheitsvorfälle) und «Major Security Incidents» (schwerwiegende Sicherheitsvorfälle). Im ersten Fall sind nur einzelne Hosts betroffen und es entsteht kein signifikanter Schaden (kein finanzieller Schaden, kein Datenabfluss, keine Reputationsschäden, keine Verletzung von Gesetzen). In so einem Falle arbeitet das Incident Response Team den Sicherheitsvorfall ab und informiert die Sicherheitsverantwortlichen. Im zweiten Fall müssen aber schwerwiegende Entscheidungen gefällt werden, welche die Kompetenzen das Incident Response Teams übersteigen. Dennoch will man aber nicht gleich eine unternehmensweite Krise ausrufen und den Krisenstab aufbieten. Hier ist einen Zwischenebene hilfreich. Diese Zwischenebene bildet das Cyber Crisis Management Team.

Aufgaben des Cyber Crisis Management Teams

Im Falle eines Major Security Incidents müssen sehr schnell wichtige Entscheidungen getroffen werden, unter anderem:

- Verfügen über weitreichende Containment-Massnahmen

- Einfordern ausserordentlicher Bereitschaft für Betreiber betroffener Systeme / Applikationen (IT SCM)

- Anordnen von Business-Continuity-Massnahmen für betroffene Systeme / Dienste / Applikationen (BCM)

- Involvierung des Versicherungspartners

- Abstimmung mit der Kommunikationsabteilung für die Kommunikation nach innen und aussen

- Bestimmung über Involvierung der Polizei/Strafverfolgungsbehörden

- Meldung einer Datenschutzverletzung an nationale Behörden

- Beauftragung einer Auswirkungs-Analyse über alle Geschäftsbereiche

Die obigen Aktivitäten sind nicht abschliessend aufgelistet und je nach Organisation müssen weitere spezifische Aktivitäten erfasst werden. Die Länge der Liste zeigt aber auf, dass ein strukturierter Ansatz gewählt werden muss und Verantwortliche gezielt geschult werden müssen.

Aufbau des Cyber Crisis Management Team

Anhand der oben aufgelisteten Aktivitäten ist ersichtlich, dass in der Regel Personen aus dem Senior Management der verschiedenen Geschäftsbereiche benötigt werden. In der Regel sind mindestens folgende Rollen Mitglieder des Cyber Crisis Management Teams:

- Leiter IT / IT Operations

- CISO (Chief Information Security Officier)

- Business-Bereichsleiter (nur falls IT-Systeme betroffen sind)

Je nach Umfeld können aber weitere Rollen integriert werden:

- Key Account Manager der IT-Provider

- Standortleiter der betroffenen Standorte

- IT-Risiko Manager

In der Regel existiert dieses Team nicht und muss zuerst organisatorisch geschaffen werden.

Ausarbeitung des Cyber Crisis Management Prozess und Checkliste

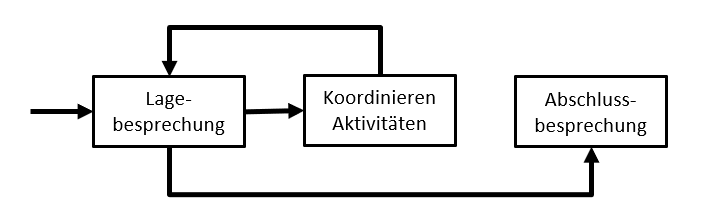

In einem nächsten Schritt wird der Cyber-Crisis-Management-Prozess ausgearbeitet. In der Regel ist dies ein simpler Prozess, welcher Iterative aus Abhalten von Lagebesprechungen sowie der kontinuierlichen Koordination der Aktivitäten beruht. Die Lagebesprechung selbst basiert auf einer Checkliste, welche bei jeder neuen Lagebesprechung abgearbeitet wird.

Abbildung 1: Beispiel – ein einfacher Prozess für Cyber Crisis Management

Onboarding des Cyber Crisis Management Teams mittels Process Walkthrough

Nun ist es an der Zeit, das Cyber Crisis Management Team zu aktivieren. Dazu wird im Idealfall ein Onboarding Workshop durchgeführt. Im ersten Teil wird ein Hintergrund über Cyber Security Incidents geben und nachfolgende Fragen werden erläutert:

- Worin unterscheiden sich ein Event, ein Alert oder ein Incident?

- Wie werden Alerts detektiert?

- Wer triagiert Alerts?

- Welche Massnahmen werden eingeleitet?

Alle Aspekte sind natürlich im Incident-Response-Prozess abgebildet. Dieser Prozess wird dem Cyber Crisis Management Team erläutert und das Team wird über seine Aufgaben, Kompetenzen und Verantwortlichkeiten informiert.

Im dritten Teil des Workshops (Prozess-Walk-Through) wird anhand eines beispielhaften Cyber Security Incidents (z.B. einer erfolgreichen Ransomware-Attacke) der Prozess Schritt für Schritt durchlaufen. Vom Eintreffen des ersten Alarms, über die Ausrufung der Cyber-Krisen bis hin zur Abarbeitung der Checkliste während der Lagebesprechung werden alle Aktivitäten der unterschiedlichen Rollen illustriert. Zum Abschluss des Workshops werden Inputs und Feedbacks der Mitglieder entgegengenommen und der Prozess sowie die Checkliste werden entsprechend angepasst.

Durchführen einer ersten Tabletop-Übung

Nun ist man bereit, die erste Tabletop-Übung durchzuführen. Das Ziel dieser ersten Übung ist es, die Grundlagen zu testen:

- Funktioniert die Einberufung des Cyber Crisis Management (z.B. automatisierter Rundruf)?

- Kennen die Mitglieder des Cyber Crisis Management Teams den Prozess?

- Finden die Mitglieder die Checkliste auf der Dateiablage? Wissen sie, wo das Dokument offline verfügbar ist?

- Ist man in der Lage, ein Protokoll zu erstellen?

- Werden die resultierenden Aufgaben ausgewogen auf die verschiedenen Mitglieder verteilt?

Aus diesen Zielen ist ersichtlich, dass das erste Tabletop-Scenario nur bedingt an die Organisation angepasst werden muss und ein sehr rudimentäres Szenario verwendet werden kann. Nach der Tabletop-Übung wird eine Nachbesprechung durchgeführt. Dabei werden gemeinsam Schwachstellen identifiziert und Verbesserungsmassnahmen adressiert.

Fazit – Krisenfähigkeit durch periodische Trainings erlangen

Es gibt verschiedene Massnahmen, um die Cyber Resilience zu erhöhen. Eine dieser Massnahmen ist der Aufbau eines Cyber Crisis Management Teams. Das Team übernimmt dann bei einem Major Security Incident den Lead und soll ein gut funktionierendes Krisen-Management garantieren. Der Aufbau eines solchen Teams kann mit relativ wenig Aufwand umgesetzt werden. Man muss einen simplen Prozess entwerfen, eine initiale Checkliste erstellen und Personen des Senior Managements dem Team zuweisen. Danach müssen die Personen mittels Onboarding über ihre Pflichten informiert werden. In der Praxis bringt dies aber erst dann einen Nutzen, wenn das Cyber Crisis Management Team periodisch (mindestens einmal im Jahr) mittels Tabletop-Übung trainiert wird. Krisenfähigkeit kann nur durch regelmässiges Training erlangt werden.

Weiterführende Links

Der Beitrag Aufbau und Ausbildung eines Cyber Crisis Management Teams erschien zuerst auf Tec-Bite.

SMTP Smuggling – eine neue Bedrohung von einem alten Protokoll

Wie sicher schon viele mitbekommen haben, wurde eine neue Schwachstelle im Simple Mail Transfer Protocol (SMTP) letzten Dezember von dem Cyber-Sicherheitsunternehmen SEC Consult publik gemacht (SMTP Smuggling – Spoofing E-Mails Worldwide – SEC Consult (sec-consult.com). Dank dieser können Angreifer Mails «schmuggeln» und somit die Authentisierungsmechanismen (SPF, DKIM und DMARC) umgehen. Somit kann sich jemand als eine komplett andere Person ausgeben und der Empfänger hat den Eindruck, dass dies eine legitime Mail ist.

Doch fangen wir von vorne an: Was ist SMTP Smuggling?

Kurz gesagt, ist es durch das SMTP Smuggling dem Angreifer möglich, gefälschte Mails zu versenden, welche dann von einem betroffenen SMTP-Server in (mehrere) einzelnen Mails aufgespaltet werden. Dies schafft der Angreifer dadurch, indem die Art und Weise ausnutzt wird, wie bestimmte Server das Ende einer SMTP-Konversation bzw. vom DATA-Befehl interpretieren.

Kurze Hintergrundinfo zu SMTP und dem DATA-Befehl:

Laut RFC5321 (RFC 5321 – Simple Mail Transfer Protocol (ietf.org)) ist der DATA-Befehl immer mit <CRLF>.<CRLF> zu beenden und <CR> oder <LF> dürfen nicht einzeln verwendet werden (datatracker.ietf.org/doc/html/rfc5321#section-2.3.8).

(CR = Carriage return (Wagenrücklauf, Zeilenanfang) | LF = Line feed (Zeilenvorschub)

(S = Server / Empfänger | C = Client / Sender)

Beispiel:

S: 220 smtp.recipientserver.com<CRLF>

C: HELO bender.ch<CRLF>

S: 250 smtp.recipientserver.com<CRLF>

C: MAIL FROM :<test@bender.ch><CRLF>

S: 250 2.1.0 OK <CRLF>

C: RCPT TO :<recipient@recipientserver.com><CRLF>

S: 250 2.1.5 OK <CRLF>

C: DATA <CRLF>

S: 354<CRLF>

C: Test Message<CRLF>

C: <CRLF>.<CRLF>

S: 250 2.0.0 OK<CRLF>

Jedoch gibt es viele Systeme (darunter auch die Cisco E-Mail Security Appliance), welche SMTP nach Postel’s Law (siehe auch RFC 761) behandeln – ganz nach dem Motto: «Be conservative in what you do, be liberal in what you accept from others». Sie akzeptieren als End of Mail Data Sequence nicht nur ein <CRLF>.<CRLF>, sondern auch andere Kombinationen wie <CR>.<CR>, <LF>.<LF> oder <CR><LF>.<LF>, um den DATA-Befehl zu beenden. Dies ist allerdings seit RFC 2821 (April 2001) nicht mehr erlaubt (datatracker.ietf.org/doc/html/rfc2821#section-2.3.7).

Wichtig ist: Es gibt sowohl das ausgehende als auch das eingehende SMTP Smuggling. Das ausgehende Smuggling betrifft die Sender Server, und wie diese sich verhalten und beim eingehenden befasst man sich mit dem Empfängerteil.

Ein kurzes Beispiel:

Ich habe meine Domäne bender.ch bei dem Mailhoster Mailhoster «CH» registriert und versende meine Mails über diesen. Dieser Mailhoster wird auch von anderen verwendet, wie auch von Robyn mit ihrer Domäne robyn.ch. Nun möchte ich an bestimmte Empfänger Mails mit der robyn.ch-Domäne senden, ohne dass Robyn etwas davon mitkriegt und die Empfänger denken, die Mail sei wirklich von Robyn versendet worden.

Durch ein <CR><LF>.<LF> im DATA-Befehl kann ich nun ohne Probleme ein weiteres Mail anfügen und somit im Namen von «robyn.ch» ein Mail an den Zielserver zu übergeben. Wichtig dabei: Beide Domains verwenden denselben Mailserver des Hosters und dieser ist für beide Domains im SPF Record eingetragen. Anbei ein kurzes Beispiel (in Grün), wie ein Mail geschmuggelt werden könnte:

(S = Server / Empfänger | C= Client / Sender)

S: 220 smtp.recipientserver.com<CRLF>

C: HELO bender.ch<CRLF>

S: 250 smtp.recipientserver.com<CRLF>

C: MAIL FROM :<test@bender.ch><CRLF>

S: 250 2.1.0 OK <CRLF>

C: RCPT TO :<recipient@recipientserver.com><CRLF>

S: 250 2.1.5 OK <CRLF>

C: DATA <CRLF>

S: 354<CRLF>

C: From : test@bender.ch<CRLF>

C: To : recipient@recipientserver.com<CRLF>

C : Subject : Test Message<CRLF>

C: Test Message<CRLF>

C: <LF>.<CR><LF> <- Hier wird das Empfängersystem überlistet!

C: MAIL FROM:admin@robyn.ch <CRLF>

C: RCPT TO :<recipient2@recipientserver.com<CRLF>

C: DATA<CRLF>

C: From : admin@roby.ch<CRLF>

C: To : recipient2@recipientserver.com<CRLF>

C: Subject : Send Information

C: Hi there<CRLF>

C: Please send me you password. <CRLF>

C: Regards, the admin<CRLF>

C: <CRLF>.<CRLF>

Wie oben ersichtlich ist, wird zuerst ganz normal eine Mail an den Empfängerserver gesendet, jedoch wird der DATA-Befehl nicht korrekt beendet und eine weitere Mail wird eingeschleust. Das Empfängersystem interpretiert aber die Zeile C: <LF>.<CR><LF> trotzdem als Ende der Mail, beginnt dann sogleich mit der nächsten Zeile und versteht dies als neue Mail vom gleichen Senderserver.

Da Robyn und ich die gleichen SPF-Einträge haben (v=spf1 include: spf.mailhoster.ch -all), wird der SPF Check auch nicht fehlschlagen, wenn die Mail in zwei Mails aufgesplittet wird.

Somit erreicht meine gefälschten Mails von robyn.ch die Empfänger ohne Probleme und wenn ich meinen Job gut gemacht habe, merken diese rein gar nichts.

Jedoch keine Panik – es gibt schon Wege, um sich davor zu schützen

Die grossen Mailhoster wie Microsoft, Google, GMX etc. haben schon reagiert und blockieren nun das ausgehende SMTP Smuggling. Somit können User von diesen Services keine Mails mehr von anderen Domänen schmuggeln.

Doch wie sieht es bei dem Empfängersystemen aus?

Auch hier haben die grössten Anbieter bei dies bei sich gefixt. Weitere Anbieter haben schon Updates oder Workarounds veröffentlicht. Auch Postfix konnte schon ein Update und Workaround veröffentlichen.

Postfix:

Exchange:

Bei Exchange On-Premises kann man anscheinend barelinefeedrejectioneneabled anpassen auf true und dann sollten solche Nachrichten abgelehnt werden.

Im Idealfall hat man aber vor dem Exchage Server ein Mailgateway, welches solche Mails dort schon abweisen kann.

SEPPmail:

SEPPmail Version 13.0.10 beinhaltet die neue Postfix-Version, welche das Problem behebt.

SEPPmail.cloud:

Benutzt ebenfalls eine neue Postfix-Version

xorlab:

Die xorlab Security Platform verwendet in Version 6.23.10 auch die neue Postfix-Version.

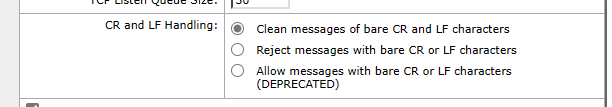

Cisco Secure E-Mail:

Bei Cisco wird das jetzige Verhalten nicht als Schwachstelle anerkannt, sondern als Feature. Man kann das Verhalten, bzw. wie die E-Mail Security Appliance die alleinstehenden <CR> und <LF> behandelt, konfigurieren und anpassen, wie man dies wünscht. Es gibt bei den Listener-Einstellungen drei Optionen:

Clean: Ergänzt automatisch alleinstehenden <CR> oder <LF> mit <CRLF>.

Reject: Blockiert eine Mail welche einzelne <CR> oder <LF> beinhaltet.

Allow: Lässt die Mail durch und ersetzt die alleistehenden <CR> oder <LF> nicht (wird in späteren Versionen nicht mehr als Option zur Verfügung stehen).

Empfehlung von AVANTEC zu Cisco E-Mail Security

Als diese Schwachstelle bekannt wurde, haben wir dies intern angeschaut und auch getestet. Bei unseren Tests wurde aber schnell klar, dass die Allow-Option keinen Unterschied bringt zu Clean und die Mails trotzdem aufgesplittet werden.

Stand 14.01.2023 testen wir noch die Option Reject auf Praxistauglichkeit, da diese die korrekte Option und Einstellung wäre, da diese RFC-konform wäre und Mails, welche alleinstehende <CR> oder <LF> beinhalten, blockiert. Bisher ist uns erst ein Absender untergekommen, welcher tatsächlich falsch formatierte Mails verschickt.

Wir empfehlen, in der E-Mail Secrutiy Appliance entweder die Mail Flow Policies so anzupassen, dass nur eine Nachricht pro Verbindung zugelassen wird:

Dadurch werden externe MTAs, welche viele Mails zustellen wollen (z.B. ein Newsletter), für jedes einzelne Mail eine neue SMTP-Verbindung aufbauen müssen. Dies führt zu einer etwas höheren Systemauslastung, wir rechnen aber mit keinen spürbaren Auswirkungen.

Oder alternativ:

Auf dem eingehenden Listener die Option Reject wählen. Dadurch werden falsch formatierte Mails sofort abgewiesen und der Sender wird eine Bounce-Meldung (Non Delivery Report) erhalten. Das Cisco Secure E-Mail Gateway wird die so abgewiesene Meldung im Mail-Log folgendermassen ausweisen: «Receiving Failed: Illegally formed message body (bare CR or LF characters).»

Weiterführende Links

www.avantec.ch/themen/e-mail-security

www.avantec.ch/loesungen/cisco-security

www.tec-bite.ch/drei-neue-features-von-xorlab-activeguard

www.tec-bite.ch/der-wahrscheinlich-einfachste-weg-an-administrative-privilegien-zu-kommen

Der Beitrag SMTP Smuggling – eine neue Bedrohung von einem alten Protokoll erschien zuerst auf Tec-Bite.

Der wahrscheinlich einfachste Weg, an administrative Privilegien zu kommen

Okta gehört zu den grössten Cloud-Identity-Providern (IdP) dieser Zeit. Letzten Oktober (2023) hatten Angreifer ein Session Cookie von einem Inhouse-Administrator abgegriffen. Mit dem Session Cookie konnten die Angreifer Namen und E-Mail-Adressen von allen Okta-Kunden abgreifen, die bis dahin den Support von Okta genutzt hatten. Das Beispiel zeigt auf, wie einfach administrative Privilegien mit einem Session Cookie gekapert werden können. Dies ist kein Einzelfall. Im Artikel zeige ich auf, wie solche Attacken verhindert werden können.

Infostealer

Im Falle von Okta entnahmen die Angreifer von einem Browser Recording HAR File das enthaltene Session Cookie. Das Session Cookie war ursprünglich für einen Inhouse-Administrator mit weitreichenden Berechtigungen ausgestellt. Dies wurde schliesslich missbraucht. Meist werden jedoch Infostealer genutzt, um an die Session Cookies von den Administratoren zu gelangen. Infostealer sind gemäss Definition von Trend Micro Trojaner, welche Informationen von einem System auslesen und weiterleiten. Meist werden Session Cookies, Credentials (also Benutzername und Passwörter) oder Tastatureingaben von Keyloggern gesammelt. Infostealer benötigen oft nur Standard-Benutzerberechtigungen, um die Session Cookies von den Browsern zu entwenden. Wer möchte kann beim folgenden Youtube Video sehen, wie Pass-The-Session-Cookie-Attacken funktionieren: www.youtube.com/watch?v=MDiwkAZ-854

Strikte Trennung von Benutzer und administrativen Tätigkeiten

Beide Angriffsszenarien haben gemeinsam, dass die Session Cookies oder Credentials auf dem Client vom Administrator vorhanden sind. Um sich effektiv vor Infostealern zu schützen, muss man ein Sicherheitskonzept haben, damit die Session Cookies, Tokens und Credentials schon gar nicht auf dem Client des Administrators vorhanden sind. Aus der Vergangenheit habe ich zwei der meist genutzten Lösungsvarianten herausgesucht, um die administrativen Sessions zu schützen. Aber wie unten beschrieben, haben auch diese Lösungsvarianten ihre Schwächen:

- Terminalserver (Admin Station):

Für administrative Tätigkeiten wird ein Terminalserver alias «Admin Station» eingesetzt. Diese Variante hat den Nachteil, dass oft Informationen wie Credentials im Zwischenspeicher zwischen Terminalserver und den Clients der Administratoren automatisch gesyncht werden. Somit haben wir wieder nicht die strikte Trennung von Benutzer und administrativen Tätigkeiten. Des Weiteren hat man keine weiteren Funktionen wie Session Recording zur Nachvollziehbarkeit oder zum Freigeben von sensitiven Zugriffen etc. Wenn der Terminalserver ein Windows-System ist, birgt es zusätzlich das grosse Sicherheitsrisiko, dass alle administrativen Credentials von allen eingeloggten Administratoren im «lsass» ausgelesen werden können.

Hier ein Artikel dazu: www.tec-bite.ch/passwordless-authentication-or-normal-it-madness - Admin-Laptop:

Administratoren haben jeweils einen Laptop für die Tasks mit Standard- Berechtigungen wie Mails lesen oder Whitepapers studieren. Fürs administrieren von Systemen besitzen die Admins jeweils einen weiteren Laptop. Dieses Gerät muss jedoch so stark restriktiert sein, dass die Tasks mit Standard-Berechtigungen geblockt werden. Heutzutage möchte man den Administratoren jedoch oft nicht mehr zumuten, dass Sie stetig zwei Laptops mit sich herumtragen. Ein weiterer grosser Nachteil dieser Lösungsvariante ist, dass man Sicherheitsfunktionen wie Session Recording oder Logging der Tätigkeiten mit weiteren Third-Party-Lösungen abdecken muss.

PAM-Konzept

Terminalserver sind grundsätzlich für Benutzer erstellt worden und der «Würgaround» mit zwei Geräten für Admins ist auch nur eine Behelfslösung. Im Werkunterricht der Schule lernt man schnell: Wenn man etwas es richtig machen will, benötigt man dafür das richtige Werkzeug oder Tool. Genauso, wie es uns die Bexio-Werbung im Jahr 2019 vermittelt hat:

Warum wenden wir das Prinzip vom Schulwerkunterricht nicht auch für das Administrieren und Verwalten unserer Systeme an?! Wie oben geschrieben, wird ein Werkzeug / Tool benötigt, das alle administrativen Session Cookies, Credentials und Tokens vom Client des Admins wegbringt. Genau dafür gibts im PAM-Bereich die All-in-One Privileged-Remote-Access-Lösung (PRA) von BeyondTrust:

Persönliches Fazit

Wenn man eine Cyber-Versicherung abschliessen möchte, dann verlangen Versicherer heutzutage, dass eine PAM-Lösung wie die von BeyondTrust eingesetzt wird. Diese Anforderung hat meiner Meinung nach auch ihre Begründung. Gerne zitiere ich hier Gartner:

«Decentralization of computing resources, channels, entities and devices makes traditional perimeter-based security strategies and tools insufficient. Security and risk management leaders must put identity at the core of cybersecurity strategy and invest in the continuous, context-aware controls.»

Gartner Identity-First Security Maximizes Cybersecurity Effectiveness, Dec 22

Wer die Administratoren effektiv schützen will, muss die administrativen Accounts, Cookies, Token etc. vom Client der Admins wegbringen. Was auf dem Client der Admins nicht vorhanden ist, kann auf dem Client nicht gestohlen werden. Zudem bringt die All-in-one PAM Lösung von Beyondtrust weiter Funktionen wie 2FA oder Session Recording für alle administrativen Session mit. Eine Übersicht zu den PRA-Funktionalitäten finden Sie hier:

www.avantec.ch/loesungen/beyondtrust/privileged-remote-access

Weiterführende Links

Der Beitrag Der wahrscheinlich einfachste Weg, an administrativen Privilegien zu kommen erschien zuerst auf Tec-Bite.

Die Darknet Trends 2024

Das Dark Web gewinnt nach wie vor unter Cyber-Kriminellen an Dynamik. Wie komplex die Ermittlungsarbeit im Darknet ist, weiss auch Serdar Günal Rütsche, Chef der Abteilung Cybercrime bei der Kantonspolizei Zürich. Wohin sich das kriminelle Ökosystem rund um den Handel mit Malware Services bewegt, welche Trends sich auf den Marktplätzen abzeichnen und welche Risiken diese Dynamik für Unternehmen birgt, wollte ich einmal selbst in den Tiefen des Darknets herausfinden.

Die letzten Wochen begab ich mich in die Foren des Onion-Netzes. Einerseits interessierte mich, was aktuell in den Hackerforen diskutiert wird, andererseits wollte ich einmal herausfinden, wie einfach es mittlerweile gemacht wird, kuriose oder gefährliche Services aus dem Darknet zu beziehen und anzubieten.

Die Probe aufs Exempel

Ich starte den modifizierten Firefox-Browser. Meine erste Anlaufstelle ist bis heute «The Hidden Wiki»: ein sehr langes Link-Verzeichnis, um auf unterschiedliche Darknet-Seiten zu gelangen. Nicht immer führen bekanntlich alle Links zum Ziel. Beunruhigend: Die seit gefühlt zehn Jahren existierende Dark-Web-Seite «Rent-A-Hacker» existiert bis heute. Verlagert hat sich bloss ein wenig das Dienstleitungsangebot: Während vor einigen Jahren für wenige 100 Euro das Hacken von E-Mail- und Facebook-Konten im Fokus lag, preisen immer mehr Cyber-Kriminelle in den Foren gerne ihre guten Social Engineering Skills an, die ein Scriptkiddie quasi als ein «All-in-One-Paket» für wenige 100 Dollar zwecks eines ganz bestimmtes Ziels hinzubuchen könnte.

Neuere Marktplätze für Drogen und Malware wollen auch mit immer mehr Sicherheit und schnelleren Servern das Vertrauen der User ergattern. Quelle: Darknet

Das Geschäftsmodell «as a Service»

Kompromittierte PayPal Accounts scheinen in letzter Zeit wieder besonders im Trend zu sein. Ob Session Cookies oder eine Kombination mit einem zusätzlichen Trojaner: Angebote zur Kompromittierung von zehn PayPal-Accounts im Wert von je 250 bis 500 Dollar kursieren bereits ab 150 Dollar in einem Darknet Market Place. Die Zahlung erfolgt dann in Kryptowährungen, zum Beispiel Bitcoin. Angereichert wird das kriminelle «as-a-Service»-Modell in manchen Fällen sogar mit Dienstleistungen wie zusätzlichen Dashboards inklusive Informationen zu Zahlungssummen und geglückten Angriffen. Das passende Ransomware-as-a-Service-Paket können sich also auch Anfänger ohne viel Vorwissen individuell konfigurieren.

Randnotiz: Es fällt mir auf, dass auf immer mehr Marktplätzen im Darknet Verkäufer und Käufer umfangreiche Bewertungen zu den Angeboten hinterlassen können. Diese Annahme bestätigt auch ein Darkweb-Security-Bericht von HP, wonach mittlerweile 92 Prozent aller Marktplätze sogar mittlerweile über eine Art Streitbeilegungsdienst-Support verfügen.

Nebst der kleinen statischen Tor-Websites tummeln sich eine Menge Diskussionsforen in der Dunkelkammer des Internets. Zu nennen wäre etwa ein «Reddit»-ähnliche Forum namens «Dread», das um die 12’000 User zählen dürfte. Diskutiert werden professionelle Hacking-Anleitungen sowie Ankündigungen oder Schliessungen von Market Places. Nebst sehr detaillierten Anleitungen zu Zero Day Exploits unter Windows wird in dem Anmelde-basierten Forum der Transport illegaler Drogen verhandelt.

Daneben existieren auch länderspezifische Foren wie «XSS», wo es (wie der Name vermuten lässt) um Cross-site Scripting und Web Vulnarability geht. Das Forum verfolgt den Zweck, Exploits, Zero Day Vulnerabilities und Credential-Datenbanken feilzubieten. Verschiedene Ransomware-Gruppen halten auch immer ganz gezielt Ausschau nach bestimmten Skills einzelner Entwickler.

Allgemein lässt sich sagen, dass sich im Dark Web mindestens drei Cyber-Hauptbedrohungen tummeln:

- Vermögens- und Identitätsdiebstahl:

Hacker verkaufen bis heute vor allem gestohlene Zugangsdaten auf Dark-Web-Marktplätzen, um auch ihrerseits von ihren Bemühungen zu profitieren. Sicherheitslücken können für finanzielle Zwecke, politische oder Unternehmensspionage oder den Diebstahl geistigen Eigentums ausgenutzt werden. - Remote Access Trojans (RAT) werden regelmässig in den Untergrundforen diskutiert. Die Anonymität gibt Hackergruppen die Freiheit, mehrere potenzielle Ziele zu planen oder auch nach neuen Malware-Schreibern für einen «Task» zu suchen.

- Zero-Day-Lücken und ungepatchte Webanwendungen:

Schwachstellen in Webanwendungen und anderen Onlinediensten gehören zu den häufigsten Bedrohungen, welche Angreifer für verschiedene Ziele ausnutzen.

Komplexe Fahndungsarbeiten bei der Polizei

«Die Strafverfolgungsbehörden der Schweiz verfügen über beschränkte Ressourcen, die gezielt nach Schwerpunkten und Prioritäten eingesetzt werden können», sagt Serdar Günal Rütsche, Chef der Abteilung Cybercrime bei der Kantonspolizei Zürich, auf die Frage, inwieweit Undercover-Arbeit bei der Verfolgung von Ransomware-Banden gegenüber anderen Delikten im Darknet überhaupt möglich ist. Man führe jährlich mehrere Strafverfahren gegen Ransomware-Gruppen, Pädokriminelle und Drogenhändlern durch.

Die Ermittlungen im Umfeld verschiedener Anonymisierungsmöglichkeiten seien oft sehr aufwendig und komplex, heisst es bei der Kantonspolizei. Man sei zwar in der Lage, jederzeit auf alle Ereignisse mit geeigneten Massnahmen zu reagieren. Dies erfordere jedoch eine ständige Weiterentwicklung der Ermittlungsmassnahmen und setze eine hohe Kooperationsbereitschaft der weltweit agierenden Strafverfolgungsbehörden voraus.

Immerhin gelingt es den Strafverfolgungsbehörden jedoch immer wieder, ein Bandennetz aufzulösen. So gelang es kürzlich, die Darknet-Plattform Kingdom Market erfolgreich abzuschalten, auf welcher über 42’000 kriminelle Angebote kursierten.

Welche Darknet-Trends sind 2024 zu erwarten?

Cybercrime als ein Produkt bzw. als ein Service ist klar im Trend. Das «as-a-Service»-Modell mit ganzen Service-Paketen für bestimmte Ziele gewinnt, ganz analog zur richtigen Geschäftswelt, an Aufwind. Für Scriptkiddies ist es immer «safer», erst einen Zugang über bereits vorhandene Hacking-Dienste zu erwerben, statt selbst Spuren zu hinterlassen.

Die Bandbreite der kriminellen Dienste im Dark Web wird allgemein immer grösser. Eine Stichprobe hat ergeben, dass etwa neun von zehn der beworbenen bekannteren Exploits in den dunklen Marktplätzen bereits für weniger als zehn US-Dollar verkauft werden, wobei die Preise für Exploits (die noch nicht publik sind) einige Tausende US-Dollar betragen können.

Security-Analysten von Check Point haben im letzten Jahr im Dark Web mehr KI-Chatbots gefunden, welche auf Large-Language-Modellen (LLM) basieren, wie sie etwa bei ChatGPT bereits Anwendung finden. So ist beispielsweise WormGPT auf KI-gesteuertes Phishing spezialisiert, insbesondere auf Business E-Mail Compromise. Ein weiteres Beispiel ist FraudGPT, ein KI-gesteuerter Chatbot, der für ein paar wenige hundert Dollar pro Monat User verleiten soll, vertrauliche Informationen von sich zu geben.

Es dürfte womöglich eine Zunahme verschiedener Darknet-Imperien aus anderen Ländern wie «XSS» geben. Alleine das russische Cybercrime-Syndikat «Hydra», bevor es im April 2022 runtergenommen wurde, machte nach Schätzungen des US-Departements für Justiz mit seinem Nettowert von über 5,2 Milliarden US-Dollar 80 Prozent aller Kryptowährungen aus.

Immer mehr im Trend: Social-Engineering-Angebote, auch bei bekannten älteren Hacker-Foren (Quelle: Darknet)

Fazit

Angesichts zunehmender Spezialisierung von Services im Darknet empfiehlt sich ein verantwortungsbewusster Umgang mit persönlichen Daten und Accounts und eine Authentifizierung über mehrere Faktoren. Dies gilt besonders für das Absichern von Fernzugängen wie VPN (RDP), Citrix, aber auch Vertragspartner und Lieferanten. Systeme oder Software, die EOL sind, sollten abgeschaltet, erneuert oder in separate Netzsegmente untergebracht werden. Um der immer professionelleren Cyber-Kriminalität entgegenzuwirken, ist eine Kombination aus verschiedenen Sicherheitsmassnahmen erforderlich wie Mail Security, Netzwerksegmentierung, EDR (oder XDR), Schwachstellen-Management und Pentesting.

Ein kontinuierliches Scannen des Dark Webs nach firmenrelevanten Daten wie E-Mail Domains, Public-IP-Adressen oder Kreditkarten-Details kann bei Firmen mit besonders riskanten Daten über Dark-Web-Monitoring-Services sichergestellt werden. Ein solcher Service detektiert frühzeitig Leaks über Ransomware Incidents und durchstöbert Dark-Web-Foren, Onion-Seiten sowie Datenbank- und Cloud-Links nach verdächtigen Informationen. So kann beispielsweise eine gestohlene Kreditkarte früh genug blockiert werden. Darüber hinaus werden mit solchen Services manchmal auch Buchstaben nachgeahmter Unternehmens-Domains identifiziert.

Weiterführende Links

www.avantec.ch/services/cyber-defense-center

www.avantec.ch/loesungen/avantec-newcomers

www.tec-bite.ch/windows-forensik-goldschuerfen-im-digitalen-raum

www.tec-bite.ch/erhoehung-der-cyber-resilience-cybersecurity-vorfaelle-richtig-trainieren

Der Beitrag Die Darknet Trends 2024 erschien zuerst auf Tec-Bite.

Drei neue Features von xorlab ActiveGuard

Seit Jahren schon starten die meisten IT-Sicherheitsvorfälle mit einem Phishing E-Mail. Viele Firmen realisieren, dass die Standard-Funktionen von Exchange Online Protection (EOP) nur einen beschränkten Schutz bieten.

Schon in früheren Blogartikeln haben wir über die Security-Plattform von xorlab berichtet:

www.tec-bite.ch/mail-authentisierungsverfahren-die-rolle-von-spf-dkim-und-dmarc

www.tec-bite.ch/malware-und-phishing-schutz-durch-vertrauens-netzwerke

www.tec-bite.ch/user-reporting-und-case-management-mal-einfach-gemacht

Kürzlich hat xorlab die neue Version 6.23 veröffentlicht. Ich will hier die Gelegenheit nutzen und die wichtigsten neuen Möglichkeiten kurz vorstellen.

ActiveGuard 6.23 – die wichtigsten neuen Features

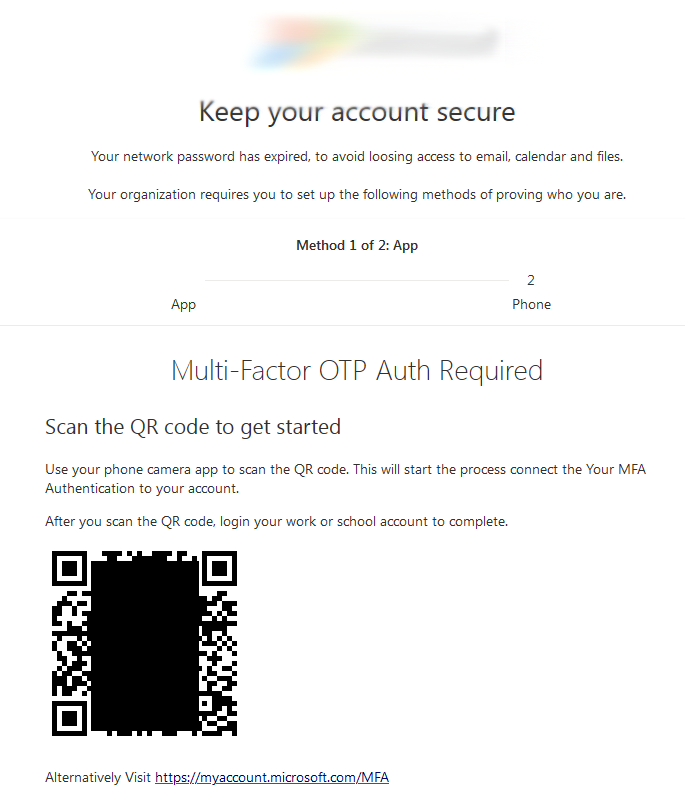

QR-Code: Eine neue Art von Phishing Mails macht seit einiger Zeit die Runde: Mails, welche einen QR-Code enthalten.

Phishing Mail, angeblich von Microsoft, mit QR-Code

Wenn man diesen Code mit seinem Smartphone einliest, wird man auf eine bösartige Webseite geleitet. Wenn man den kodierten Link auf seinem Firmen-PC anklicken würde, so würde der Zugriff hoffentlich vom Proxy blockiert. Das Smartphone ist jedoch ungeschützt. Zeigt die bösartige Webseite eine Kopie der Microsoft-Login-Seite, so ist das Risiko gross, dass ein unvorsichtiger User seine Domain Credentials eingibt. Der Phishing-Versuch ist geglückt!

Um diesen Angriffsvektor für Firmenmails zu unterdrücken, hat ActiveGuard nun eine QR-Code Detection eingeführt. Erstens erkennt ActiveGuard QR-Codes (diese sind in Mails an sich schon verdächtig), zweitens wird die kodierte URL extrahiert und wie ein anklickbarer Link beurteilt.

Ich kenne keine andere Mailsecurity-Lösung, die das zurzeit kann.

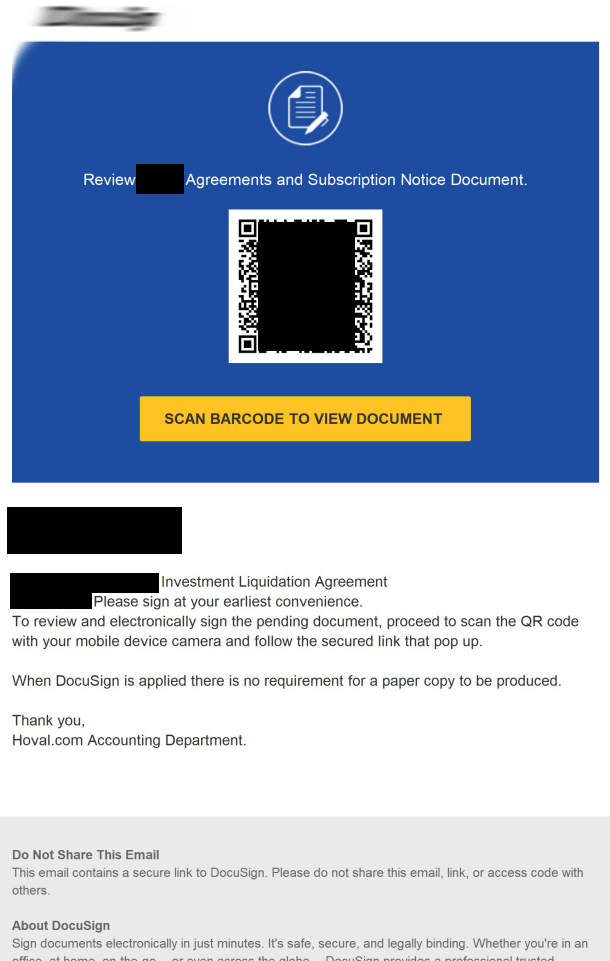

Phishing Mail, angeblich von DocuSign, mit QR-Code

URL Shortener

URLs werden auch gerne hinter URL-Shortenern wie tinyurl.com und ähnlichen versteckt und so verschleiert. ActiveGuard kann nun noch mehr solche URLs auflösen als bisher.

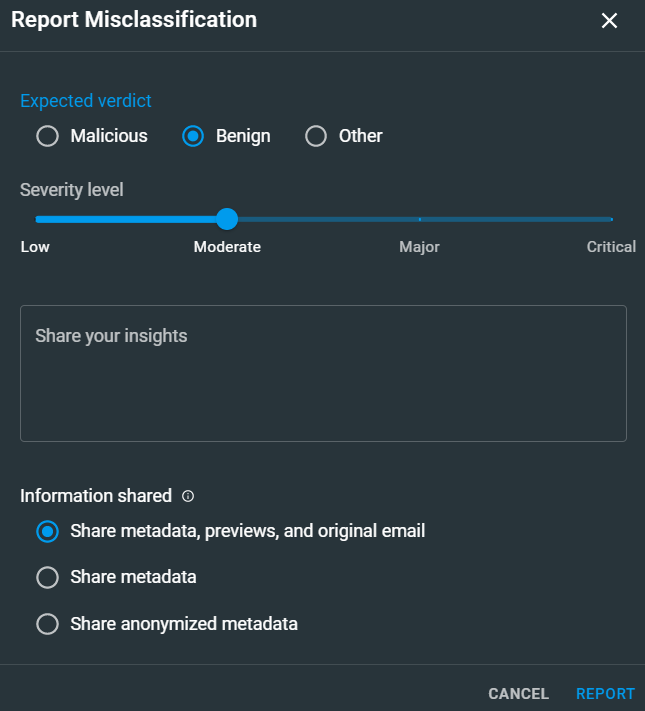

Misclassification Submission

Obwohl ActiveGuard auch in dieser Version die Erkennung von bösartigen Mails weiter verbessert und die Blockierung von False Positives minimiert, kann es trotzdem zu einer falschen Klassifizierung kommen. Neu können Admins falsch erkannte Mails per Knopfdruck an xorlab melden, damit die Erkennung weiter verbessert werden kann. Dabei lässt sich einstellen, welche Daten übermittelt werden sollen: das ganze Mail oder nur anonymisierte Metadaten.

Admins können neu falsch erkannte Mails per Knopfdruck an xorlab melden.

Schlussbemerkung

Ich finde, die neuen Features sind eine enorme Verbesserung der Plattform. Insbesondere das QR-Code Feature finde ich wichtig, da man damit verhindern kann, dass die Mitarbeitenden ihr privates Smartphone zum Scannen des QR-Codes zücken und so die Corporate Security Werkzeuge umgehen.

Weiterführende Links

AVANTECs E-Mail Security Portfolio: www.avantec.ch/themen/e-mail-security

Der Beitrag Drei neue Features von xorlab ActiveGuard erschien zuerst auf Tec-Bite.

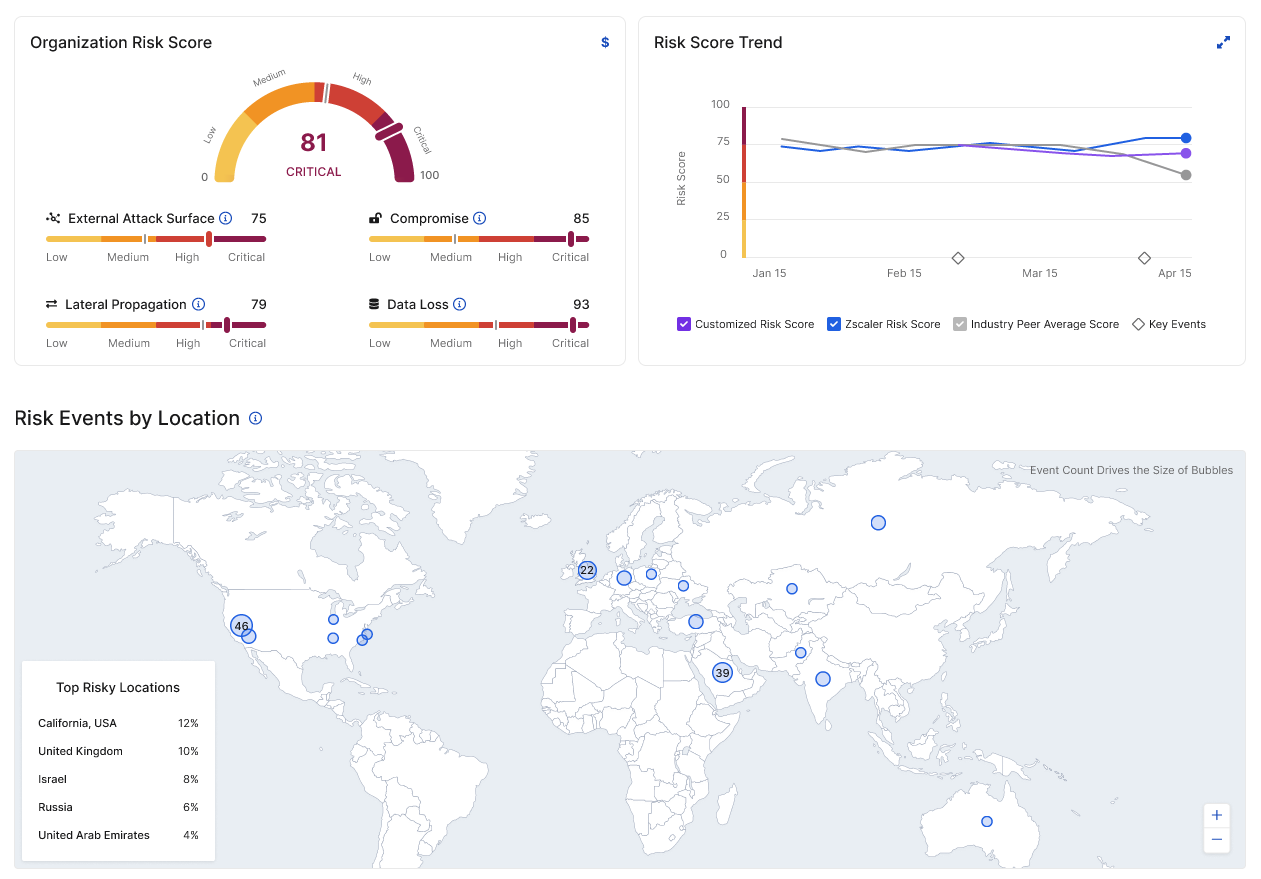

Risikobewertung für jede Phase eines Sicherheitsverstosses: Zscaler Risk360

Möchte ein CISO der Unternehmensleitung darlegen, wie es mit dem Schutz des Unternehmens steht und welche Risiken vorhanden bzw. wie teuer diese sind, so muss er heute viele verschiedene Tools wie z.B. Vulnerability Management, Compliance-Systeme, Tabellen usw. konsultieren und die Kennzahlen manuell zusammensuchen. Mit einem neuen Tool namens «Risk360» funktioniert dies automatisch. In diesem Post möchte ich euch kurz zeigen, was dieses Tool kann und wie es das Leben der CISOs erleichtert.

Zscaler Risk360

Zscaler liefert über die Risk360-Plattform automatisch viele aktuelle Datenpunkte und Informationen, die verarbeitet werden. Vorgestellt wurde die Lösung erstmalig an der Zscaler Zenith Live in Berlin und ab Anfang August 2023 war sie dann als Beta verfügbar. Die Preise sind noch nicht öffentlich verfügbar, aber jeder Zscaler-Kunde kann die Lösung jetzt schon testen. Einen kleinen Vorgeschmack für Nicht-Kunden gibt der folgende kleine Test unter: testmydefenses.com/ransomware-assessment

Quelle: www.zscaler.com/blogs/company-news/introducing-zscaler-risk360-tm-measuring-risk-holistically, abgerufen am 24.11.2023

Das kann Risk360

Laut Zscaler umfassen die Grundfunktionen von Risk360 mehrere Phasen eines Sicherheitsvorstosses: In erster Linie die externe Angriffsfläche, in zweiter Linie auch die laterale Ausbreitung eines Angriffs. Durch die Vernetzung und Korrelation zwischen Ermittlungsworkflows, Richtlinien und Risikobewertungen lassen sich Behebungsmassnahmen aufgrund granularer Datenanalysen priorisieren und umsetzen. Im Fokus stehen sowohl die Verhinderungsstrategie von Datenverlust als auch die frühzeitige Erkennung eines Angriffs mittels zahlreicher Risikofaktoren, basierend auf externen Datenquellen wie Zscaler ThreatLabz sowie vorhandenen Daten aus Zscaler Internet Access (ZIA), Zscaler Private Access (ZPA), Zscaler Deception usw.

Inkludiert sind darüber hinaus die Visualisierung und das Reporting sowie die finanziellen Auswirkungen von Ereignissen. Auch ist die automatische Erstellung einer wöchentlicher 10- bis 15-seitigen PowerPoint-Präsentationsvorlage enthalten, die als Grundlage zur regelmässigen Präsentation vor der Geschäftsleitung verwendet werden kann.

Schliesslich ermöglicht das Tool konkrete Vorschläge, wie die Risiken gesenkt werden können und das Aufzeigen der Risikoentwicklung über einen längeren Zeitraum hinweg.

Fazit

Aus meiner Sicht sehe ich einen grossen Nutzen durch die automatisch berechneten Risk Scores, welche die eigenen Risiken im Vergleich zum Branchendurchschnitt aufzeigen. Für die Geschäftsleitung sind vermutlich vor allem die Zahlen wichtig, d.h. wie hoch die Kosten eines Risikos im Vergleich zur Einführung einer neuen Sicherheitslösung sind.

All dies vereinfacht die Tätigkeit des CISOs und er kann sich den wichtigeren Dingen widmen.

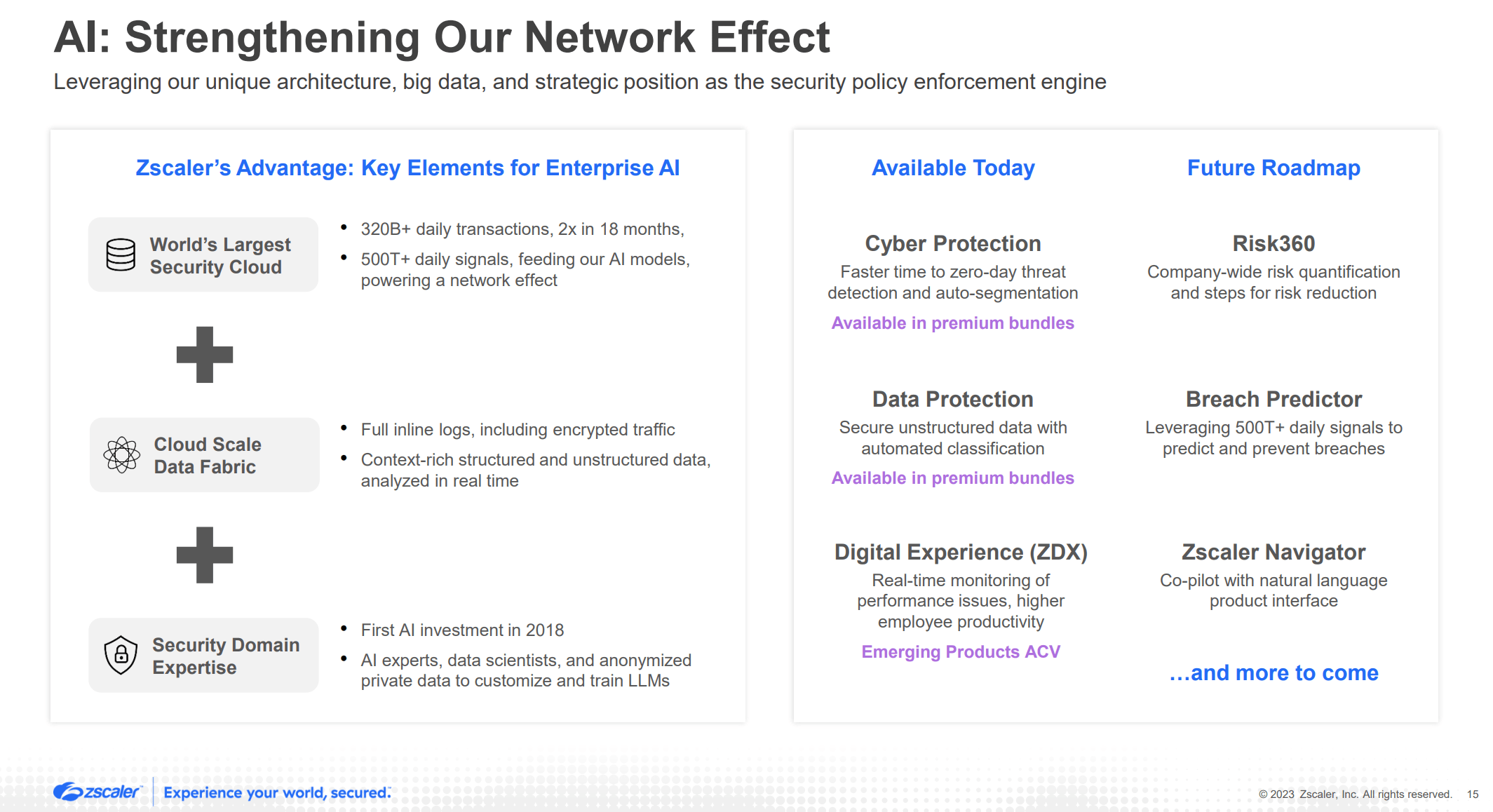

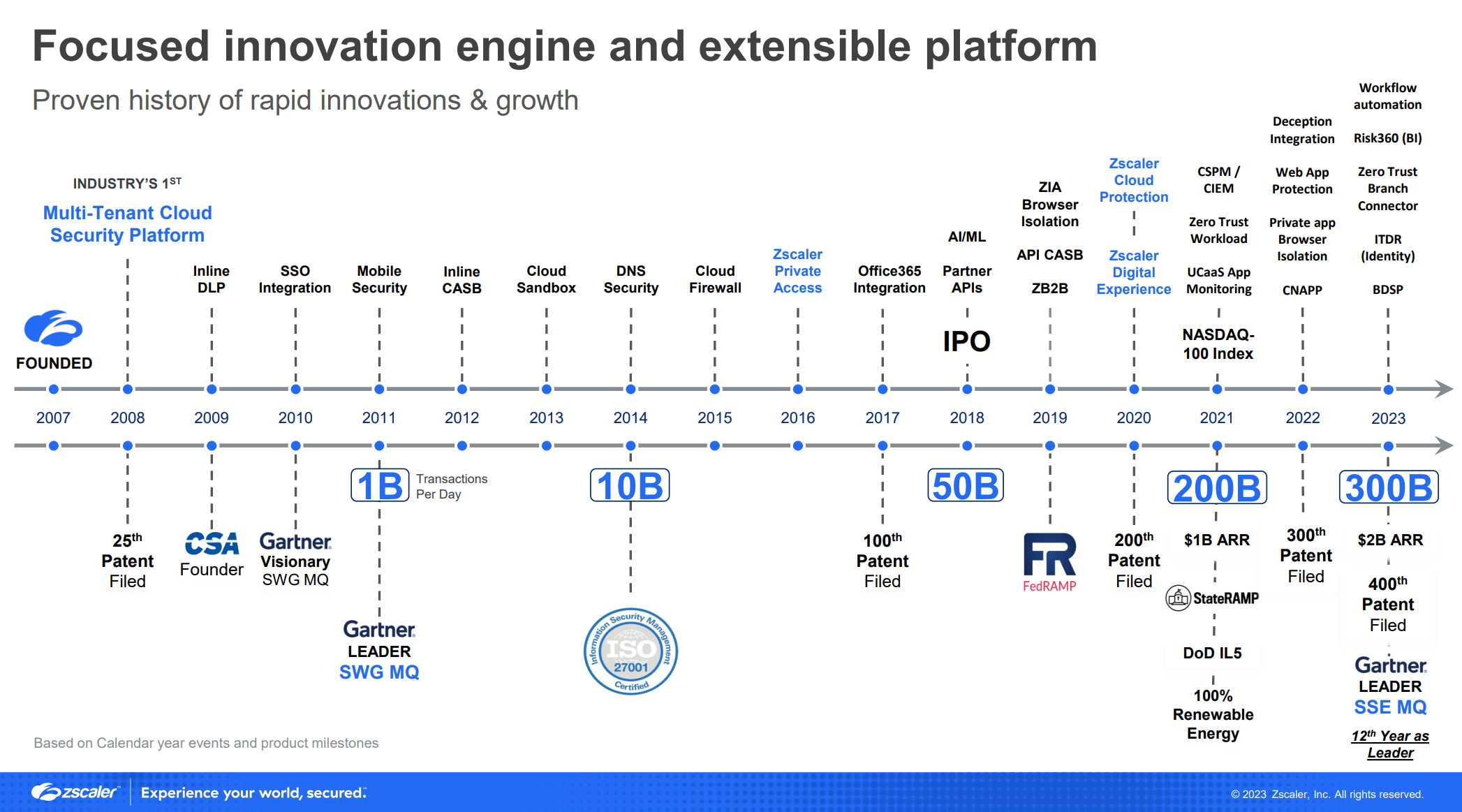

Übrigens: Zscaler verfolgt eine AI Roadmap

Mittelfristig hat Zscaler weitere Integrationen von künstlicher Intelligenz zur Unterstützung der Admins geplant. Aber hier darf ich eigentlich noch nichts Weiteres verraten. Alles ist streng geheim und womöglich ändert sich die Roadmap noch mehrfach.

Aber als kleiner Vorgeschmack auf zukünftige Entwicklungen kann man Zscalers öffentliche Geschäftsberichte konsultieren und dort hats Hinweise auf (mögliche) zukünftige Innovationen, gerade im Bereich künstlicher Intelligenz.

Quelle: Zscaler Q4’23 Call Presentation (Seite 15), ir.zscaler.com/static-files/fb613854-06cf-4277-94ca-c4dc95399e79, abgerufen am 24.11.2023

Facts & Figures über Zscaler

- Zscaler zählt aktuell über 7700 Kunden und schützt über 41 Million User.

- 40 Prozent der «Fortune 500»- sowie 30 Prozent der «Forbes Global 2000»-Unternehmen sind Zscaler-Kunden.

- Zscaler ist seit zwölf Jahren «Gartner MQ Leader» in Secure Service Edge (SSE) und Secure Web Gateway (SWG).

- Zscaler schützt den User, den Workload, die Applikation, den B2B-Remotezugriff, die IoT/OT-Geräte usw.

Und noch vieles mehr …

Weiterführende Links

www.avantec.ch/loesungen/zscaler

www.zscaler.de/products-and-solutions/zscaler-risk-360

Der Beitrag Risikobewertung für jede Phase eines Sicherheitsverstosses: Zscaler Risk360 erschien zuerst auf Tec-Bite.

Virtuelle Smart Cards – geht das?

Smart Cards sind mit ihrer Hardware-basierten Sicherheit und den asymmetrischen kryptografischen Algorithmen die wohl sichersten 2FA-Möglichkeiten und mit Zertifikaten kann man noch digital signieren und hochsichere Verschlüsselungen realisieren. Hier sind Haben und Wissen so vereint, dass man keine Shared Secrets (Seeds oder Hashes) hinterlegen muss und den «Passcode» weder abfangen noch bewusst weitergeben kann. Die Identität wird auf Basis des Digital-Signing-Prinzips verifiziert. Das Verfahren ist schematisch (unter https://www.tec-bite.ch/smart-cards-what-happens-in-the-background) dargestellt. Auch die asymmetrische Verschlüsselung des Kerberos-Protokolls ist damit wesentlich sicherer.

Aktuelle Angriffe auf höhere Lehranstalten der Schweiz zeigen, dass auch interne Credentials sehr im Fokus der Hacker stehen und im Darknet gehandelt werden.

Warum sollte man nun auf den Gedanken kommen, diese Authentisierung zu virtualisieren?

- Organisatorischer Aufwand beim Versenden oder der Ausgabe der Credentials

- Smart Card Replacement on Demand

- Support auf Plattformen in denen, die Smart Card nicht nutzbar ist, etwa bei VDI-Umgebungen oder BYOD

- Post-Quantum Cryptography

Eigentlich ist das schon ein altes Thema.

Ein Blick in die Geschichte der Virtual Smart Card

Aladdin hatte schon vor über 15 Jahren mit dem eToken Virtual TMS 2.0 und dem eToken Rescue im TMS 5.0 eine Variante für zertifikatsbasierte Authentisierung, um den Verlust einer Smart Card oder des eToken temporär abzufedern.

Microsoft – Virtual Smart Card wurde dann zu «Windows Hello for Business» und die Keys liegen verbindlich im Trusted Plattform Module (TPM). Diebstahl der Keys wird so schon sehr schwierig.

Eine weitere Variante bietet Versasec mit ihrer Virtual Smart Card:

Und auch von Gemalto – heute Thales – kennen wir einen durchaus anspruchsvollen Ansatz. Hier liegen die privaten Schlüssel hochsicher in einer Datenbank, die mit einem Hardware Security Module (HSM) abgesichert ist und damit bleibt die Idee Hardware-basierten Sicherheit erhalten. Aber dazu später mehr.

Um die Entwicklung darum wirklich zu verstehen, müssen wir vielleicht mal einen Schritt zurücktreten und uns die Anforderungen und Herausforderungen mit Smart Cards anschauen. Die Vorteile einer Smart Card als Zertifikatsträger sind oben genannt, aber es gibt dabei auch Herausforderungen und zusätzliche Anforderungen.

Die Herausforderungen bei der Virtualisierung der Smart Card

Wir brauchen eine PKI, die uns vertrauenswürdige Zertifikate erstellt und ab einer gewissen Grössenordnung auch eine Smart Card Management System – siehe «vSEC:CMS»-Artikel.

Die Logistik für das Verteilen, Erneuern – und bei Verlust das Ersetzen der Karten, inklusive der zuverlässigen Identifizierung der Besitzer – ist ein nicht zu unterschätzender Aufwand. Auch das Installieren und Aktualisieren der Middleware kann Zeit und Nerven kosten, wenn man an BYOD denkt.

Die operativen Aufgaben zum Entsperren oder Erneuern der Zertifikate sind dabei eher einfache und gut gelöste Aufgaben im Lifecycle einer Karte mit einem Smart Card Management.

Der Einsatz dieser Authentisierung ist auf den beliebten mobilen Geräten eine fast unmögliche Herausforderung. Nicht nur wegen des fehlenden Smart Card Slots. NFC gibt es auch für Smart Cards schon lange. Nur müsste der Zugang freigeschalten sein. Dieser ist auch bei iOS-Geräten noch immer eingeschränkt. Die Verwendung der Smart Cards über einen separaten Bluetooth Reader war nicht von Erfolg geprägt.

Zertifikate auf dem mobilen Gerät ablegen geht schon, aber der Schutz des Private Keys ist nicht mit einer Smart Card zu vergleichen. Leider. Dabei würde es doch zumindest auf einigen Geräten vergleichbare Chips für Hardware-basierte Sicherheit geben, wobei dann das Access Device und das Authentication Device nicht getrennt wären.

Ähnliche Herausforderungen stellen sich teilweise mit VDI-Lösungen. Und bei diesen verschiedenen Szenarien kann eine Virtualisierung der Smart Card ein Segen sein.

Es scheitert auch an einer generellen Schnittstelle, welche für Apps prädestiniert wäre, um die kryptografischen Prozesse sicher zu nutzen. Die Apps müssen auch entsprechend programmiert sein.

Hier verlässt man sich auf FIDO2 und die rein Key-basierte Authentication ohne Trust, Validity, Revocation, Subject … Womit man auf eine PKI verzichten kann. Hatte man das nicht als einen Mangel bei SSH-Key-based Authentication identifiziert?

Das ist nun einmal für den Consumer-Markt konzipiert und es muss beim Einsatz im Unternehmensumfeld optimiert werden.

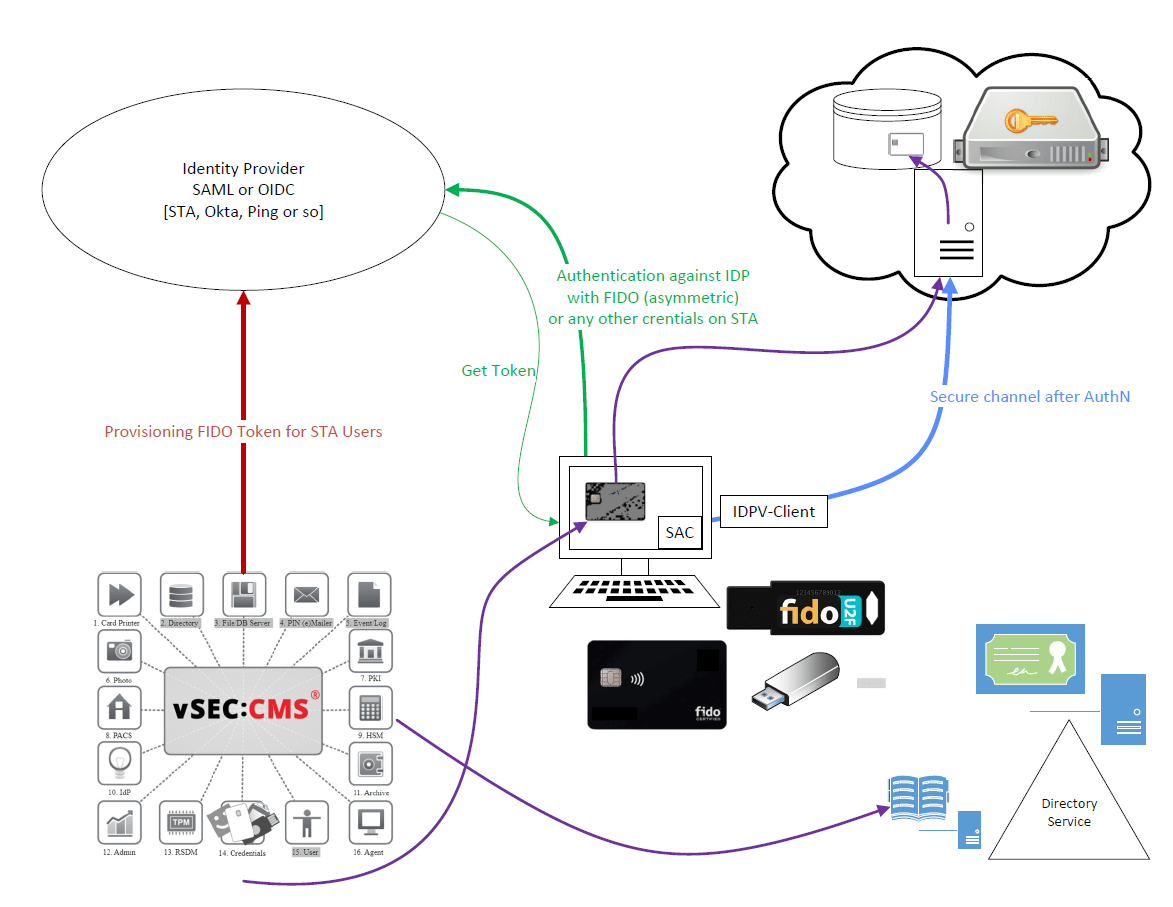

Um einige dieser Challenges anzugehen und dennoch ein möglichst hohes Sicherheitsniveau zu gewährleisten, könnte man nun die virtuelle Karte via Netzwerk zur Verfügung stellen.

Also wir legen die Keys in einer DB ab, die mit einem HSM abgesichert ist und regeln den Zugriff für die Benutzer mit einem zentralen Identity Provider (IdP). Wenn der IdP nun die Authentisierung mit einem FIDO-Geräte unterstützt sind beide Steps (Authentisierung via IdP und die Smart-Card-Operation asymmetrisch). Bei einer Authentisierung mit OTP oder anderem fallen wir in diesem Punkt auf symmetrische Sicherheit zurück. Hier ist also eine Access Policy wichtig, die regelt, für welchen Verwendungszwecke welche Authentisierung gefordert wird, aber die Karte mit dem Zertifikat wäre im Falle eines Verlustes «on Demand» verfügbar. Wenn das Gerät – ein zertifikatsbasiertes Windows Logon – oder die VDI-Maschine keine Smart Cards unterstützt, wäre auch dafür eine Lösung gegeben.

Das HSM anzugreifen, ist wohl eher das Letzte, was man versuchen würde; alle anderen Steps muss man genauer betrachten, um die Sicherheit hochzuhalten: Ganz nach dem Motto: «Secure the Weakest Link».

Damit erweitern wir die Verfügbarkeit der Smart Cards und gerade für alle Digital Natives und bei den Firmen wäre eine grosse Herausforderung an die Logistik adressiert.

Vor allem die digitale Unterschrift (Digital Signing) von E-Mails oder Dokumenten lässt sich so auch ohne eine physische Karte abbilden und ist nicht mit OTP-Verfahren oder FIDO zu ersetzen. Und ja, es gibt auch die Möglichkeit, Zertifikate für E-Mail Signing und Encryption auf einem Gateway zu hosten, aber dann genau für diesen Verwendungszweck. Logon bei Windows für Unternehmen lässt sich hingegen noch nicht mit FIDO abbilden.

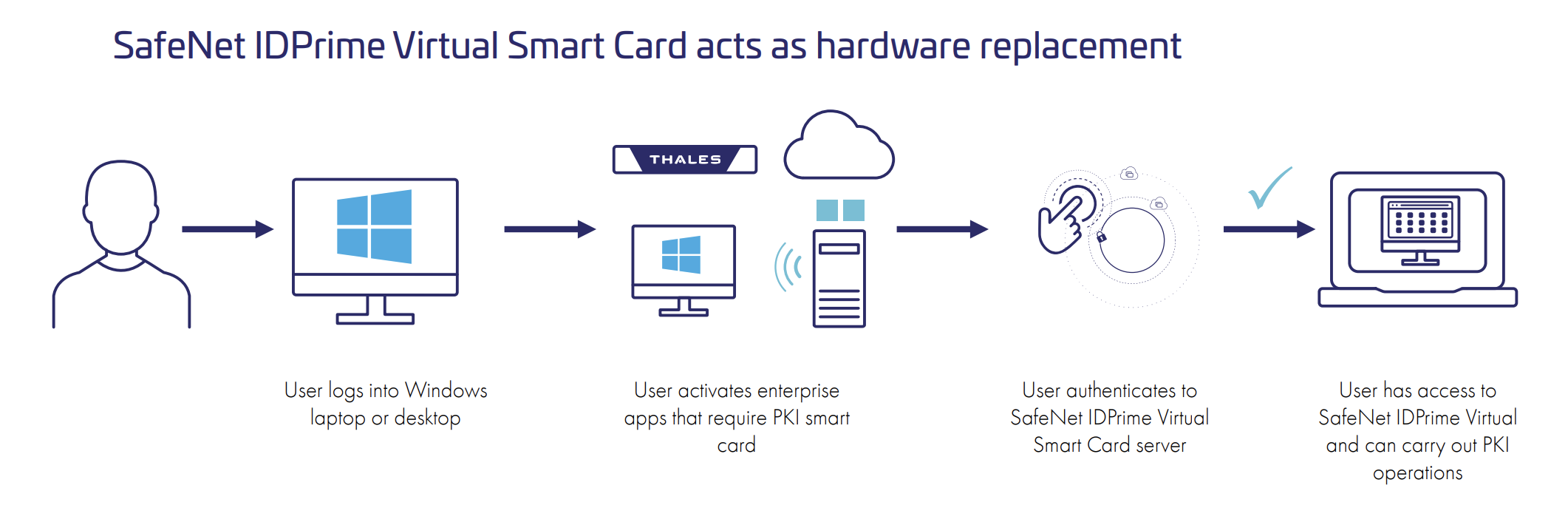

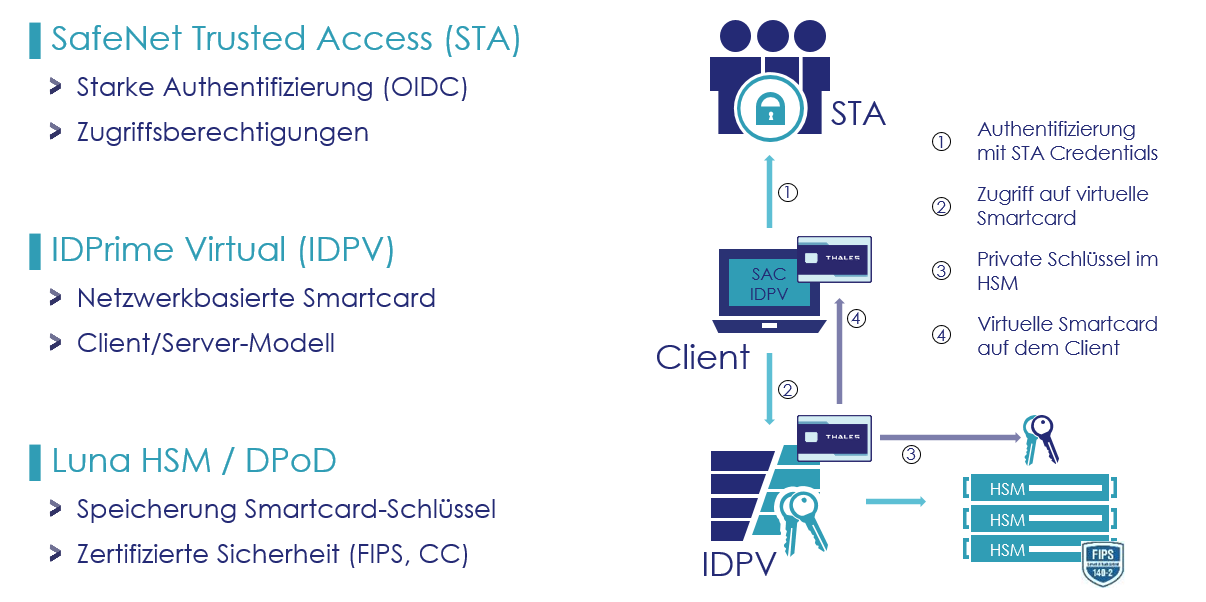

Generelle Darstellung des IDPrime Virtual Systems

Mit den Steps als Beschreibung zum Ablauf:

- Rot – Enrollment des FIDO Tokens – hier könnte auch das Card Management von Versasec und die Lösung SafeNet Trusted Access von Thales helfen.

- Grün – Authentication mit dem FIDO Token am Identity Provider (IdP)

- Blau – Access Virtual IDPrime Virtual Service (IDPV) – Smart Card verfügbar

- Purple – Das Card Management kann auch zur Verwaltung und zum Enrollment des Zertifikats verwendet werden.

Enrollment Smart Card – IDPrime Virtual (IDPV)

Für den Zugriff auf die Smart Card braucht man folgende Komponenten: Als Middleware wir der altbekannte SafeNet Authentication Client (SAC) verwendet. Als Quasi-Smart-Card-Reader «over the Net» wird der IDPV-Client verwendet, der also die Kommunikation zum IDPV-Service realisiert. Zur Authentisierung für diesen Zugriff wird jetzt der Identity Provider (IdP) via SAML bemüht. Wie die Authentisierung dort erfolgt, also mit welchem Authenticator und welche Access-Regeln dort definiert sind, ist die Aufgabe des IdPs. Im Falle von SafeNet Trusted Access sind verschiedenste Möglichkeiten bis zu FIDO2 mit entsprechenden Access-Regeln geboten.

Damit der User diese Möglichkeit nutzen kann, ist das Enrollment manuell oder automatisiert via Versasecs «vSEC:CMS» möglich. Nun brauchen wir natürlich noch ein Zertifikat auf unserer virtuellen Smart Card. Der SAC lässt sich hier wie gewohnt verwenden und auch hier ist ein manueller Import möglich, aber auch hier kann der «vSEC:CMS» für das Enrollment der Zertifikate von der definierten Zertifizierungsstelle der internen PKI oder auch von externen Trust Centern.

Für Offline-Verwendungen kann das Zertifikat im TPM des Clients abgelegt werden.

Das Zertifikat kann dann wie mit einer physischen Karte, wie gewohnt, verwendet werden.

So wird die Sache rund.

Es ist eine komplexe Struktur mit einigen Komponenten, aber eine sichere Basis für zertifikatsbasierte Anwendungsfälle, ohne Abstriche an der Sicherheit, on Demand verfügbar, wenn der User das benötigt, ohne Organisation des Shippings und der Verifizierung der User vor Ort.

Fazit aus meiner Sicht

Wer eine wirklich sichere Authentisierung benötigt, muss den Aufwand betreiben, eine Smart Card in Form einer ID-1 Card oder eines USB-Tokens als Zertifikatsträger zu betreiben. Die Kombination mit weiteren Einsatzzwecken, wie beim Sichtausweis, der Bezahlung in der Cafeteria, dem Gebäudezutritt, der Zeiterfassung, dem Secure Printing haben usw., haben wir schon öfters betrachtet … Und der ganze Aufwand ergibt Sinn.

Das Sicherheitsniveau und der zu betreibende Aufwand müssen aber festlegt werden und stehen immer im Kontext des zeitlichen und finanziellen Aufwands. Da kann es durchaus Sinn ergeben, wenigstens asymmetrische Verfahren wie FIDO2 im Kontext mit Cloud-Lösungen zu verwenden, weil diese nur dies unterstützen oder auch virtuelle Smart-Card-Systeme in Betracht zu ziehen, um die Verfügbarkeit asymmetrischer Verfahren zum Beispiel für das Signieren von Dokumenten, E-Mails oder auch zertifikatsbasierten Authentisierungen auf Plattformen ohne Smart Card Support zu bieten.

Im Folgenden der Step-by-Step-Ablauf bei Thales IDPrime Virtual (IDPV)

Im ersten Schritt erfolgt die Authentifizierung per Open ID Connect (OIDC) an einem entsprechenden Identity Provider (IDP) wie beispielsweise SafeNet Trusted Access (STA). Nach erfolgreicher Multi-Faktor-Authentisierung (MFA) entsprechend der dort hinterlegten Anmelderichtlinien erhält der User Zugriff auf den IDPV Server, der dessen virtuelle Smart Card bzw. die zugehörigen Keys auf dem HSM mit seinem Client verknüpft. Die virtuelle Smart Card wird transparent im Betriebssystem eingeblendet. Aus OS-Sicht ist dies identisch mit dem Einlegen einer physischen Smart Card in den Reader.

Nun kann der Anwender die auf der virtuellen Karte gespeicherten Zertifikate für nachfolgende Anmeldungen, digitale Signatur oder die Verschlüsselung seiner E-Mails verwenden. Sobald dafür der Zugriff auf die Private Keys erforderlich ist, muss der User sich durch Eingabe seiner PIN an der Karte nochmals authentifizieren. Die eigentliche Krypto-Operation wird dann über das Netzwerk an das HSM geschickt, mit dem dort liegenden Private Key des Anwenders ausgeführt und das Ergebnis zurück an den Client geschickt.

Die Sicherheit des Gesamtsystems hängt dabei von der Sicherheit der Authentifizierung am IDP sowie der PIN der virtuellen Karte ab. Wenn der User die Karte an einem anderen System benötigt, dann kann er diese mit dem neuen Client verbinden. Sie folgt also dem User entsprechend seiner Anmeldung an weiteren Systemen.

Weitere Flexibilität ermöglichen dabei Optionen wie ein IDPV Credential Provider, der die Verbindung zur Virtual Smart Card vor dem Windows Logon durchführen kann, um danach eine zertifikatsbasierte Anmeldung bei Windows durchführen zu können. Auch eine Offline-Nutzung ist möglich, indem die virtuelle Smart Card für eine limitierte Zeitspanne auf dem TPM des Windows Clients gespeichert werden kann.

Weiterführende Links

www.avantec.ch/loesungen/thales

www.tec-bite.ch/passwordless-authentication-or-normal-it-madness

www.tec-bite.ch/kryptoanalyse-das-brechen-einer-verschluesselung

www.tec-bite.ch/smart-card-ein-kleines-kunstwerk

www.tec-bite.ch/cyber-security-ist-teuer-auch-gleich-besser

www.tec-bite.ch/quantensichere-kryptographie-von-mathematischer-theorie-zu-konkreten-standards

Der Beitrag Virtuelle Smart Cards – geht das? erschien zuerst auf Tec-Bite.

8 Trends in der Cloud Security

Mehr als zwei Jahrzehnte seit Beginn der Cloud-Computing-Ära beobachten führende Cloud-basierte Endpoint-Protection-Anbieter wie CrowdStrike noch immer viele Unternehmen, die zahlreiche unbeabsichtigte Fehler in der Cloud begehen.

Die Verlagerung in die Cloud ist jedoch nicht aufzuhalten. Die Analysten von IDC prognostizieren, dass beispielsweise die Cloud in Asien gar bei 65 Prozent von 2000 Unternehmen bis 2025 On-Prem als primärer Speicherort der betrieblichen Daten ablösen wird. Auch die oft zitierten Gartner-Analysten meinten bereits vor anderthalb Jahren, dass mehr als die Hälfte aller Unternehmensausgaben für Anwendungs- und Infrastruktursoftware sowie Geschäftsprozessdienste und Systeminfrastruktur bis 2025 in die Cloud fliessen dürften.

Warum mehr in die Cloud Security investiert wird

Die Einführung bringt aber auch einige Security-Anforderungen mit sich. Zu den wichtigsten Prioritäten und Challenges aller Branchen zählen laut eines Cloud Security Reports von Fortinet und «Cybersecurity Insiders» erhöhte Kosten, Compliance-Anforderungen, aber auch die Komplexität von Hybrid- und Multi-Cloud-Lösungen sowie eine geringere Transparenz und der Mangel an qualifizierten Fachkräften. Dies wiederum führt zu einer Verlangsamung der Cloud-Einführungsstrategien. Zudem überrasche es nicht, dass Sicherheitsbedenken in Bezug auf die Cloud weiterhin ein entscheidendes Hindernis darstellen. Trotz wirtschaftlicher Faktoren und Verzögerungen beim Umstieg auf Cloud-Lösungen werden 60 Prozent der Unternehmen mehr in die Cloud Security investieren. Zur höchsten Cloud-Security-Priorität zählen mehr als 51 Prozent der Befragten die Vermeidung von Fehlkonfigurationen. Die Sicherung von Anwendungen, die in die Cloud verlagert wurden, steht bereits an zweiter Stelle (48 Prozent).

Laut Trend Micro besteht die grösste Unternehmens-Herausforderung in der Inkonsequenz. Diese liege zumeist darin begründet, dass bereits einzelne Richtlinien in der einen oder anderen Cloud-Anwendung völlig anders implementiert sein könnten. Trend Micro geht davon aus, dass es aufgrund dieser uneinheitlichen Situation zu Sicherheitsvorfällen kommen wird, da viele Chief Information Security Officers (CISOs) noch nicht mit den neuen Technologien vertraut sind, geschweige denn über die Kapazität verfügten, alle Cloud-Installationen überwachen zu können. Man rechne zudem vermehrt mit Fehlkonfigurationen auf Benutzerseite und vielen Herausforderungen seitens der Entwickler. Die Cloud-Entwickler würden zwar immer agiler, schreibt Trend Micro, könnten jedoch die Sicherheit im Laufe ihrer Entwicklung auf die lange Bank schieben.

Acht Cloud-Security-Trends werden in daher aus meiner Sicht auch in den nächsten Jahren die Sicherheitsstrategie rund um die Cloud dominieren:

1. Zero Trust Security

Die Adaption eines Zero-Trust-Security-Modells, das auf strikte Identitäts-Verifikation setzt, wird vermehrt Zuspruch erhalten, besonders in Cloud-Umgebungen. Ein Zero-Trust-Modell ersetzt grösstenteils den traditionellen Sicherheitsansatz, bei welchem bislang vorwiegend der Perimeter verteidigt wurde. Eine Zero Trust Network Architecture (ZTNA) beschreibt de facto ein gesamtes Sicherheitsmodell, das davon ausgeht, dass Bedrohungen sowohl innerhalb als auch ausserhalb eines Netzwerks vorhanden sind. Folglich besteht mit Zero Trust eine strenge Überprüfung jedes Nutzers und jedes Geräts, bevor ein Zugriff auf interne Ressourcen ermöglicht wird.

2. Künstliche Intelligenz

Ende November hat OpenAI die Anwendung ChatGPT auf den Markt gebracht. Eines ist sicher: Entwicklerkonzerne werden AI und Machine Learning weiter stark vorantreiben und in Echtzeit auf Security-Bedrohungen antworten wollen, um Schwachstellen schneller erkennen zu können. Um die KI im IT-Security-Umfeld ranken sich aber auch einige Mythen: Zwar lassen sich dank künstlicher Intelligenz ein grosser Stack an Datenmengen analysieren und angemessene Gegenmassnahmen einleiten. Eine weitreichende Übergabe von Handlungskompetenzen an die KI wird man jedoch in naher Zukunft nicht erleben. Es wird daher auch weiterhin nötig sein, menschliche Akteure in die Detektion von Schwachstellen einzubinden.

3. Security by Design

Security by Design ist ein Designansatz, welcher die Sicherheit der Hard- oder Software über den gesamten Lebenszyklus eines Produkts gewichtet. Das heisst, Cloud-Plattformen dürften in Zukunft stärker von Anfang an in das Design und deren Infrastruktur investieren, statt später mit Sicherheitsaktualisierungen nachzubessern. Die Vorteile durch Security by Design resultieren beispielsweise in einem reduzierten Risiko für Sicherheitslücken und Schwachstellen in der Hard- und Software, in einer höheren Robustheit und im Idealfall in ein grösseres Vertrauen in die Produkte.

4. Mikrosegmentierung

Bei einer Mikrosegmentierung werden Netzwerke in logische und sichere Einheiten aufgeteilt. Mikrosegmentierung unterstützt Networking, indem «demilitarisierte Zonen», also Computernetze mit sicherheitstechnisch kontrollierten Zugriffsmöglichkeiten, erstellt werden. Um Lateral Movements innerhalb einer Cloud-Umgebung zu verhindern, werden Unternehmen vermehrt auf Mikrosegmentierung setzen und ihr Netzwerk in kleinere und stärker isolierte Segmente aufteilen.

5. Container Security

Container Security beinhaltet den Schutz der Infrastruktur, der Laufzeitumgebung und der dazwischenliegenden Bereiche. Container benötigen weniger Systemressourcen und haben die Art und Weise, wie Software entwickelt und verwaltet wird, revolutioniert. Zwar gibt es auch Nachteile bei der Komplexität – jedoch sind Container ein begehrtes Mittel zur Bereitstellung und Paketierung von Anwendungen.

6. Cloud Posture Management

Gemäss Gartner werden bis 2025 bis zu 99 Prozent der Security Incidents in der Cloud vom User versursacht. Ein wirksames Cloud Security Posture Management (CSPM) mittels Tools von Drittanbietern ermöglicht die Überwachung von Fehlkonfigurationen in Public Clouds. Dank der automatischen Behebung von Fehlkonfigurationen in IaaS-, PaaS- und SaaS-Umgebungen lassen sich viele fehlerhafte Settings und in verschiedenen Cloud-Umgebungen bzw. Infrastrukturen automatisch beheben.

7. Passwordless

Immer mehr Tech-Konzerne wie Microsoft und Google setzen schon auf passwortlose Authentisierung und setzen auf die FIDO-2.0-Authentifizierungsspezifikationen, die auf Public-Key-Kryptographie und internationalen Standards basieren, um eine passwortlose Authentifizierung auf mehreren Geräten zu ermöglichen. Zu gängigen Enterprise-Adoptionen im Sicherheitsbereich zählen unter anderem FIDO (Fast Identity Online) und Public-Key-Infrastrukturen (PKI). Vor allem der consumernahe FIDO-Standard verzichtet auf Zertifikate, Komplexität und Kosten, was jedoch als Unternehmensanwendung zum Nachteil werden kann, der mit einem Enterprise Identity Provider (IdP) wettgemacht werden muss. Es lohnt sich allerdings, die Bedürfnisse im Unternehmen genau zu identifizieren.

8. Zunahme von Cloud Access Security Brokers (CASBs)

Über einen Cloud Access Security Broker wird sichergestellt, dass Daten bei der Übertragung in und aus der Cloud sicher bleiben. CASBs werden mehr und mehr von Organisationen eingesetzt, damit Unternehmen den Zugriff auf Cloud-Dienste besser überwachen und kontrollieren wollen.

Fazit

Mit der Zunahme von Cloud-Migrationen hinterlassen mehr Unternehmen ihren digitalen Fussabdruck. Allgemein hat laut des «Global Threat Report 2023» von CrowdStrike die Zahl an Exploits in der Cloud während des Jahres 2022 um 95 Prozent (!) zugenommen. Die Bandbreite reicht von Fehlkonfigurationen bis hin zu mehr Credential-Abgriffen, beispielsweise bedingt durch zunehmende Social-Engineering-Attacken. Von einer ansteigenden Tendenz an möglichen Fehlkonfigurationen, verhängnisvollen Control-Panel-Übergriffen und vermehrten identitätsbasierten Angriffsarten ist in dem Bericht ebenfalls die Rede.

Es wird daher auch immer wichtiger, Multi-Cloud-Lösungen korrekt zu konfigurieren und sich bei «grossen Anbietern» alleine nicht in Sicherheit zu wägen, sondern auch Lösungen von Drittanbietern Betracht zu ziehen. Auch der zunehmende Fachkräftemangel stellt Unternehmen vor neue Herausforderungen, weswegen auch Grossunternehmen stärker von externen Anbietern abhängig werden. Diesen Problemen kann beispielsweise mit skalierbaren Endpoint-Detection- oder Managed-Detection-and-Response- (MDR-)Lösungen begegnet werden. MDR (Managed Detection & Response) ist eine Kombination aus führenden automatisierbaren Detection-Lösungen und geschulten Mitarbeitenden. Ein erfahrenes Team aus Cyber-Spezialisten kümmert sich dann um die Incidents, welche im Vorfeld durch die maschinellen Algorithmen detektiert werden.

Weiterführende Links

www.avantec.ch/themen/cloud-security

www.tec-bite.ch/cyber-security-ist-teuer-auch-gleich-besser

www.tec-bite.ch/einfuehrung-in-zero-trust-ein-paradigmenwechsel

www.tec-bite.ch/cloud-security-posture-management-was-habe-ich-davon

www.tec-bite.ch/die-risiken-von-chatgpt-kennen

www.tec-bite.ch/erhoehung-der-cyber-resilience-cybersecurity-vorfaelle-richtig-trainieren

Der Beitrag 8 Trends in der Cloud Security erschien zuerst auf Tec-Bite.

Kryptoanalyse – das Brechen einer Verschlüsselung

In unserer heutigen Zeit sind wir ständig von der Kryptografie umgeben und sie begleitet uns durch den Alltag – sei es beim E-Banking auf dem Smartphone, beim sicheren Einkauf beim Onlineshopping oder auch beim Versenden einer E-Mail. Die Sicherheit in der Informatikwelt ist ein wichtiger Bestandteil und ist heutzutage gar nicht mehr wegzudenken. Auch in der Wissenschaft werden ständig Untersuchungen durchgeführt, um zu analysieren, wie sicher aktuelle Verschlüsselungsmethoden sind.

In diesem Blogbeitrag werden wir uns gemeinsam mit der Kryptoanalyse auseinandersetzen, um einen kleinen Einblick in dieses interessante, aber auch komplexe Thema zu erhalten. Dabei bin ich kein Experte in diesem Fachgebiet, jedoch habe ich während meines Studiums im Modul «Kryptologie» einige interessante Dinge zu diesem Thema dazugelernt.

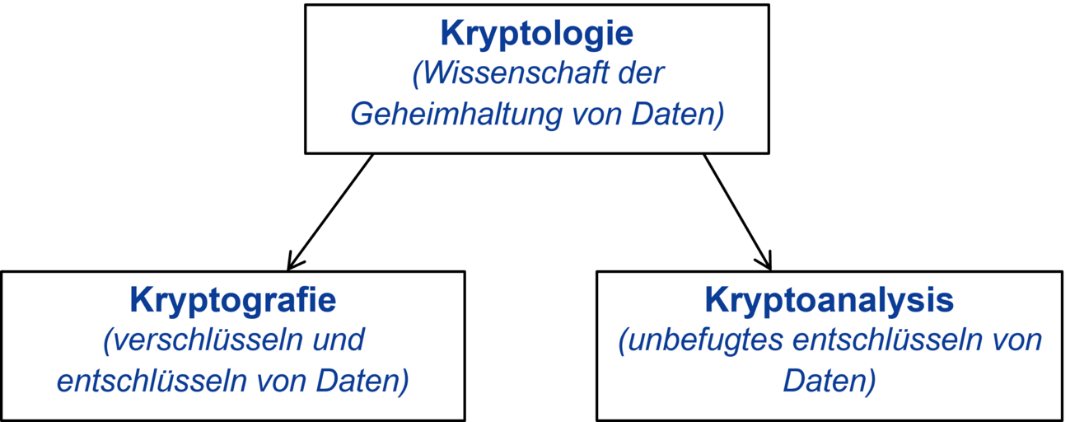

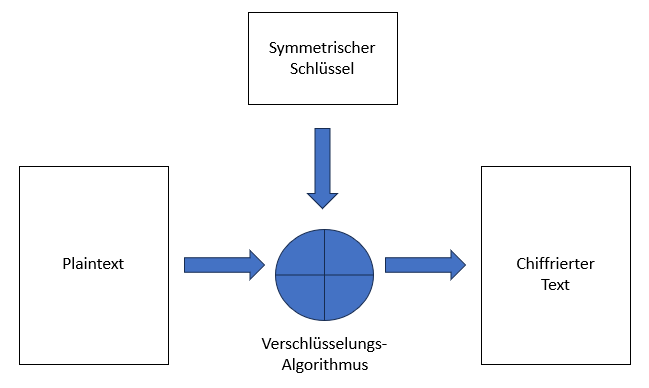

Bevor wir aber dazu kommen, wäre es noch interessant zu erfahren, woher das Wort «Kryptoanalyse» überhaupt stammt. Dieses Gebiet ist ein Teilbereich aus der Kryptologie, welches sich aus der Kryptografie und der -analyse bildet. Das Wort Kryptologie steht für «geheim» und setzt sich mit der Wissenschaft des Verschlüsselungsverfahrens auseinander. Oftmals ist es der Fall, dass die beiden Wörter Kryptologie und Kryptografie miteinander verwechselt werden, obwohl es sich hier nicht ganz um das Gleiche handelt. Die Kryptoanalyse beschäftigt sich mit der Praxis, kryptografische Systeme zu analysieren, um deren Schwachstellen zu identifizieren. Das Ziel besteht darin, Chiffren zu entschlüsseln, ohne den geheimen Schlüssel überhaupt zu kennen.

Angriffsmöglichkeiten in der Kryptoanalyse

Für den Kryptoanalytiker gibt es unterschiedliche Möglichkeiten, um einen gezielten Angriff durchzuführen. Hier kommt es vor allem auf die verfügbaren Informationen an, welche ein Angreifer bereits besitzt. Je mehr Informationen jeweils vorhanden sind, desto höher ist die Erfolgschance bei der Analyse. Hierfür gibt es drei unterschiedliche Methoden für einen Angreifer:

1. Ciphertext-only-Attacke (Geheimtext ist bekannt)

- Bekannte Informationen: Der chiffrierte Text (Output)

- Ziel des Angriffs: Kenntnis über den Input und/oder den Schlüssel

Im ersten Verfahren ist dem Angreifer nur der verschlüsselte Text bekannt. Dabei sind keine Informationen zum Klartext oder dem Schlüssel bekannt.

2. Known Plain-Text-Attacke (Klartext bekannt)

- Bekannte Informationen: Teile vom Input oder dem chiffrierten Text (Output)

- Ziel des Angriffs: restlicher Input und/oder der Schlüssel

Bei dieser Angriffsmethode verfügt der Angreifer Informationen über gewisse Paare vom Klar- und dem chiffrierten Text.

3. Chosen-Plain-Text Attacke (frei wählbarer Klartext)

- Zugriff des Angreifers: Krypto-Modul mit dem geheimen Schlüssel

- Bekannte Informationen: Frei wählbarer Input und der Output davon

- Ziel des Angriffs: Schlüssel

Im letzten Verfahren hat der Kryptoanalytiker die Möglichkeit, anhand des verwendeten Verschlüsselungsgeräts einen beliebigen Klartext zu verschlüsseln.

Kerckhoffs’sche Prinzip

Ein bekannter Grundsatz in der Kryptografie für die Gestaltung und Bewertung von Verschlüsselungssystemen ist das Kerckhoffs’sche Prinzip. Es besagt, dass immer angenommen werden sollte, dass dem Angreifer das kryptografische System bekannt ist und nicht unterschätzt werden sollte. Zudem sollte die Sicherheit eines Verschlüsselungssystems allein auf der Geheimhaltung des Schlüssels basieren und nicht auf der Geheimhaltung des Verschlüsselungsalgorithmus.

In der Vergangenheit wurde schon oft bewiesen, dass die Geheimhaltung eines Verfahrens nicht viel gebracht hat. Es ist lediglich eine Praxis, um die Sicherheit eines Systems durch die Verschleierung der Implementierung zu gewährleisten (dem sogenannten «Security through Obscurity»). Stattdessen sollte jedoch auf bewährte Sicherheitsmechanismen und Verschlüsselungsalgorithmen gesetzt werden. Wenn wir auf die Geschichte zurückblicken, wäre ein bekanntes Beispiel dafür das 2G-Protokoll GSM (Global System for Mobile Communications). Hier basierte die Verschlüsselung auf die Stromchiffre und einem zuvor geheimen Algorithmus. Dieser wurde jedoch zu einem späteren Zeitpunkt veröffentlicht, sodass festgestellt wurde, dass die A5/1-Verschlüsselung unsicher war und durch den A5/3-Algorithmus ersetzt werden musste.

Methoden in der Kryptoanalyse

Brute-Force-Attacke

Eine der bekanntesten Methoden in der Kryptoanalyse, um eine Verschlüsselung zu knacken, ist ein Angriff mittels Brute Force. Dabei geht der Angreifer systematisch vor und versucht, alle Kombinationen, ohne das Passwort oder den Schlüssel zu kennen. Ziel all dessen ist es, den Zugang zu einem gesicherten System oder einer Datei zu erhalten. Dabei hängt der Zeitaufwand von der Schlüsselraumgrösse ab, da dieser je nach Grösse aufwendiger wird.

Es gilt jedoch als grundlegende Annahme, dass es nie wert ist, dieses Verfahren zur Entschlüsselung anzuwenden. Stattdessen wird mit dem Einsatz von ausgeklügelten Verfahren ein besserer Ansatz angegangen, um an eine Entschlüsselung zu kommen.

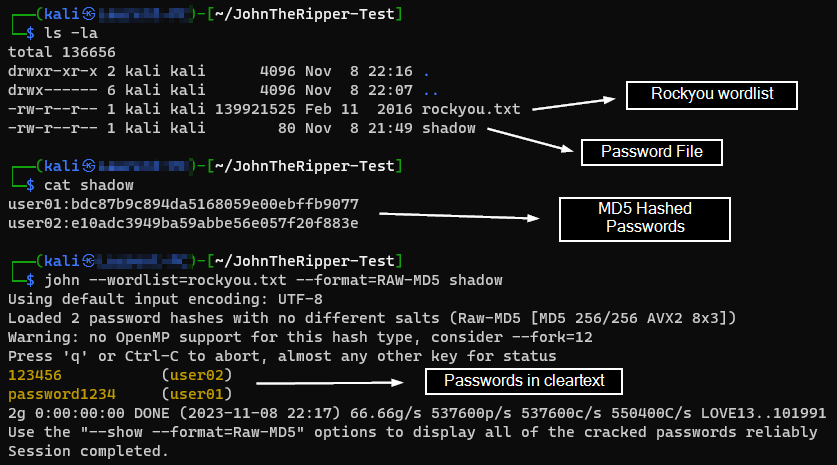

Wörterbuchangriff (Dictionary Attack)

Ein weiteres beliebtes Verfahren ist der Wörterbuchangriff. In dieser Methode besitzt der Angreifer eine Liste von Wörtern – oftmals in diesem Fall Passwörter. Diese werden nacheinander gegen ein System geprüft, bis alle Einträge getestet wurden oder eines erfolgreich funktioniert. Solch ein Angriff kann sehr effektiv sein, falls das Opfer ein schwaches oder oft genutztes Passwort verwendet.

Eine bekannte Anwendung, die für solche Attacken verwendet werden kann, ist «John the Ripper», ein Open-Source-Tool. Auch hier kann eine angepasste Liste häufiger Wörter verwendet werden, bei welcher der jeweilige Output mit dem chiffrierten Passwort verglichen wird.

Aus diesem Grund sollte auch überprüft werden, ob bei der Konfiguration eines Systems gewisse Passwortanforderungen wie die Mindestanzahl von Zeichen oder die Wiederverwendung gesetzt werden können, um die Sicherheit gegen solche Wörterbuchangriffe zu erhöhen.

Seitenkanal-Attacke (Side-Channel Attacks)

Letzteres schauen wir uns noch Side-Channel-Attacks an. Wie der Begriff schon sagt, werden in dieser Methode Nebenkanal-Informationen analysiert, um an die geheimen Informationen zu kommen. Dadurch kann der Verschlüsselungsprozess umgangen werden, ohne direkt das System oder den Algorithmus zu brechen.

Ein Verfahren wäre die Analyse des Stromverbrauchs, bei welcher eine Schlussfolgerung anhand der durchgeführten Operationen eines Prozessors oder dem aktuellen Verbrauch gemacht werden kann. Ebenfalls kann anhand von Timing Attacks, dem Messen der Zeit für bestimmte Operationen oder auch bei der Analyse der Speichernutzung eines Prozesses, ein Angriff erfolgen. Zu den bekanntesten Sicherheitslücken gehören auch Spectre und Meltdown aus dem Jahre 2017. In beiden Fällen wurde diese Methode dazu verwendet, um unbefugten Zugriff auf den Speicher anderer Prozesse zu erhalten.

Weitere interessante Beispiele von Side-Channel Attacks gibt es unter folgendem Link:

https://cseweb.ucsd.edu/classes/wi22/cse127-a/scribenotes/6-sidechannels-notes.pdf

Fazit

Wir haben die verschiedenen Angriffsmöglichkeiten in der Kryptoanalyse beleuchtet und das Kerckhoffs’sche Prinzip hervorgehoben, das die Annahme betont, dass Angreifer das kryptografische System kennen. Weiterhin wurde erläutert, dass die Geheimhaltung eines Verfahrens allein nicht ausreicht, um Sicherheit zu gewährleisten, und dass bewährte Sicherheitsmechanismen und Verschlüsselungsalgorithmen von grosser Bedeutung sind.

Schliesslich haben wir einige Methoden in der Kryptoanalyse behandelt, darunter die Brute-Force-Attacke, den Wörterbuchangriff und Seitenkanal-Attacken. Hier wurde betont, dass es oft sinnvoller ist, auf ausgeklügelte Verfahren und bewährte Sicherheitsmechanismen zu setzen, anstatt Brute-Force-Methoden anzuwenden.

Die Kryptografie und ihre Analyse werden auch in Zukunft eine Schlüsselrolle für die Sicherheit unserer digitalen Welt spielen und erfordern fortlaufende Aufmerksamkeit und Innovation.

Weiterführende Links

Der Beitrag Kryptoanalyse – das Brechen einer Verschlüsselung erschien zuerst auf Tec-Bite.