Windows-Forensik – Goldschürfen im digitalen Raum

Beim Thema Forensik habe ich jeweils sofort die High-Tech Labs von CSI Las Vegas, CSI New Orleans, oder wie die Serienableger alle hiessen, vor meinem geistigen Auge. IT-Nerds in weissen Kitteln, vor Screens mit allerlei Animationen, in Räumen voller Server Racks mit blinkenden Lichtern, die unheimlich kompliziert aussehende, hochstehende wissenschaftliche Sachen machen. Nicht unbedingt so fancy, aber mitunter vielleicht genau so nerdig, geht es im wahren Leben in der digitalen Forensik zu. Die digitale Forensik umfasst dabei viele verschiedene Teilbereiche, wie zum Beispiel unterschiedliche Betriebssysteme, Cloud, industrielle Steuerungssysteme (ICS) oder Mobile Devices. In diesem Artikel will ich versuchen, einen ersten Einblick in den Bereich der Windows-Forensik zu geben. In einem zweiten Artikel gehen wir dann etwas tiefer und schauen uns an, was man so alles finden kann.

Um was geht es bei der digitalen Forensik überhaupt?

Definition der digitalen Forensik laut NIST:

«In its strictest connotation, the application of computer science and investigative procedures involving the examination of digital evidence – following proper search authority, chain of custody, validation with mathematics, use of validated tools, repeatability, reporting, and possibly expert testimony.»

Kurzum: die Beschaffung von digitalen Beweisen unter Einhaltung wissenschaftlich fundierter Methoden.

Spurensicherung – aber gewusst wie

Gerade, aber natürlich nicht nur, wenn es dabei um einen Rechtsfall geht, ist es äusserst wichtig, dass die Beschaffung der digitalen Beweise gewissenhaft dokumentiert wird. Dies aus mehreren Gründen: Zum einen ist es nicht möglich, forensische Untersuchungen auf einem laufenden System durchzuführen, ohne dass dabei gewisse Änderungen vorgenommen werden, beispielsweise in Form geschriebener Logfiles oder gestarteter Prozesse. Die Dokumentation dient also dazu, diese Änderungen zu protokolieren. Und zum anderen wird durch die Dokumentation eine Wiederholbarkeit durch einen weiteren Experten möglich. Zudem gilt es, den Umfang des Durchsuchungsbeschlusses genau zu beachten, um den erlaubten Bereich der Untersuchung nicht zu übertreten. Aktuelle Streifragen in dem Zusammenhang betreffen beispielsweise die Datenablage auf Cloud Storage: Gehören diese Daten zum Computer und somit zum Durchsuchungsbeschluss für den PC der verdächtigen Person? Google Drive, Dropbox oder OneDrive werden auf dem Rechner als lokale Laufwerke angezeigt, die Daten liegen aber auch in der Cloud. Huhn-Ei-Problem oder?

Alles, was wir auf unseren Rechnern tun hinterlässt Spuren, man spricht dabei von «Artifacts». Jedes Programm, das wir starten, jedes Mail, das wir öffnen, jede Website, die wir besuchen. Und ja, auch beim Private Browsing, aka «Porno-Modus», hinterlässt man Spuren. Mit den richtigen Methoden und Tools können all diese Dinge und vieles mehr in den Unmengen an Logfiles und Events gefunden werden.

Welche Daten sind im Fokus?

Daten können zum einen von der lokalen Harddisk eines Rechners / Servers und zum anderen vom Memory (RAM) beschafft werden. Die Harddisk stellt dabei das «Langzeitgedächtnis» dar, die Daten darauf sind hautsächlich in Form von Dokumenten und (Log-)Files gespeichert. Eine immer grössere Herausforderung stellt dabei die Full Disc Encryption oder File Encryption dar. Für den Endanwender (oder Kriminellen) eine gute Sache; für den Analysten eher nicht so. Das RAM kann als «Kurzzeitgedächtnis» verstanden werden, in dem volatile Daten für den schnellen Zugriff griffbereit zwischengelagert werden. Wird der Rechner heruntergefahren, sind die Daten im RAM futsch. Um möglichst viele Daten beschaffen zu können, ist es daher äusserst wichtig, eine Erst-Analyse am laufenden System durchführen zu können, möglichst mit noch eingeloggtem User. Ein System im laufenden Betrieb zu analysieren, bietet unter anderem Zugriff auf folgende Daten im RAM:

- Encryption Keys / Passwörter (Diese lassen sich mit entsprechenden Tools aus dem Memory auslesen.)

- Laufende Prozesse

- Netzwerkverbindungen (z.B. C2-Verbindungen von Malware)

- Private Browsing Sessions (im Private Mode werden keine Browsing History oder Cache-Informationen auf die Disk geschrieben, jedoch ins Memory)

- Informationen zu offenen Files, Verzeichnisstrukturen oder verbundenen Geräten

- Aktuell verwendete Registry Keys

- «File-less» Malware (z.B. Rootkits oder maliziöse Scripts)

- Entschlüsselte Disk (Drive Encryption)

- Entschlüsselte Files, sofern der Benutzer noch eingeloggt ist und die Files entsperrt hat (File Encryption)

Wird der Rechner mit aktivierter Disk Encryption heruntergefahren, sprengt der Aufwand, um die Disk zu entschlüsseln, den Rahmen der allermeisten Ermittlungen (zu aufwendig, zu langwierig, zu teuer). Gleiches gilt auch bei Mobile Devices, da auch hier bei aktuellen OS-Versionen standardmässig eine Verschlüsselung aktiviert ist, sowohl auf Android wie auf iOS Geräten. Ein Tool, das hilft, herauszufinden ob Disks verschlüsselt sind, ist Encrypted Disk Detector (www.magnetforensics.com/resources/encrypted-disk-detector).

Hat man Zugang zur Harddisk oder einem Disk Image, findet man unteranderem folgende Daten:

- Pagefile.sys und swapfile.sys

- Hiberfil.sys (was im Endeffekt eine komplette Kopie aller Daten vom RAM enthält, zu dem Zeitpunkt als das System in den Hibernate-Mode gewechselt hat)

- Master File Table $MFT

- AppData-Verzeichnis (z.B. für Registry Hive NTUSER.DAT)

- Diverse Logfiles, Datenbanken und Windows Event Log

- Normale Dokumente wie Office oder PDF Files etc.

- Vermeintlich gelöschte Dateien

- Registry Hives unter C:\Windows\System32\config

- Browser Cache

Wie gelangt man an die Daten im RAM?

Daten im RAM können natürlich nicht so ohne Weiteres mit dem File Explorer ausgelesen werden. Dazu benötigt es entsprechende Tools und etwas Fachwissen.

Es gibt viele unterschiedliche Tools um Memory Images zu erstellen, sowohl frei verfügbare Open Source Tools wie z.B. WinPmem (github.com/Velocidex/WinPmem) oder auch kommerzielle Anwendungen wie F-Response (www.f-response.com).

Hat man sein Image erst mal erstellt, geht es nun daran die Daten zu analysieren. Auch dafür gibt es frei verfügbare Tools wie z.B. Volatility (github.com/volatilityfoundation/volatility3) oder kommerzielle Tools wie Magnet AXIOM (www.magnetforensics.com/products/magnet-axiom).

Eine gute Übersicht über Tools für Akquisition wie auch Analyse findet man hier: github.com/digitalisx/awesome-memory-forensics

Harddrive-Analyse

Wie oben gelistet, findet man auf der Disk eines Rechners Unmengen an forensisch interessanten Daten, wie z.B. Logs, Registry Hive Files, Browser Cache und Windows-System-Datenbanken. Diese Informationen braucht Windows, um beispielsweise die Grösse und Position der einzelnen Fenster, die letzte Position in einem Wordfile oder den Strombedarf der verschiedenen Applikationen zu tracken. Auch Informationen zu kürzlich verwendeten Dateien (MRU – Most Recently Used), eingegebenen Pfaden im Windows Explorer oder eingegebene Suchbegriffe in der Windows Search können als Beweismittel dienen. Die wenigsten Benutzer geben den Pfad direkt im Explorer ein, sondern klicken sich durch die Struktur, bis sie am gewünschten Ort sind. Findet man also interessante Sachen in der File Path History, ist das ein gutes Indiz, dass jemand genau wusste, was wo zu finden ist. Gleiches gilt auch für die Suchfunktion.

Eine der besten Quellen für Informationen zu ausgeführten Applikationen, Netzwerkaktivität und Energienutzung der letzten 30 Tage ist die System Resource Utilization Management (SRUM) Database. Auch hierfür gibt es verschiedene Tools, welche die SRUM DB in lesbarer Form als CSV-Dateien exportieren. Mehr Infos dazu findet man hier: digitalforensicsdotblog.wordpress.com/tag/srum

Eines der Tools ist «srum-dump», das hier zu finden ist: github.com/markbaggett/srum-dump

Ich gehe an dieser Stelle nicht tiefer in die Analyse der Daten ein. Dazu folgt zu einem späteren Zeitpunkt ein weiterer Artikel. Zusammenfassend lässt sich aber sagen, dass es in der Forensik viel Fachwissen braucht, was die zu analysierenden Systeme angeht, sowie Zeit und Geduld. Moderne Tools machen einem das Leben zwar einfacher, trotzdem muss man wissen was man tut. Ganz so wie beim Goldschürfen in der freien Natur

Weiterführende Links

www.tec-bite.ch/cyber-security-ist-teuer-auch-gleich-besser

www.tec-bite.ch/einfuehrung-in-zero-trust-ein-paradigmenwechsel

www.tec-bite.ch/die-risiken-von-chatgpt-kennen

www.tec-bite.ch/erhoehung-der-cyber-resilience-cybersecurity-vorfaelle-richtig-trainieren

Der Beitrag Windows-Forensik – Goldschürfen im digitalen Raum erschien zuerst auf Tec-Bite.

Make or buy: Wenn die Eigenentwicklung zu lange dauert

Perimeter 81 ist eine erst fünfjährige Firma, die komplett der Cloud verschrieben hat und eine Lösung für alle Themen bietet, welche wir aktuell unter Secure Service Edge (SSE) zusammenfassen. Eine Plattform, welche die Themen des SSE auf eine einfache aber schlagkräftige Art lösen soll. Die Firma, deren Gründer bereits die Firma Safer VPN gegründet hatten, wird nun also ein Teil einer der grössten Cyber-Security-Firmen.

Seit ein paar Wochen ist die Lösung bereits in der Preisliste von Check Point integriert und löst als «Quantum SASE» Harmony Connect ab, welche die bisherige SSE-Lösung des Anbieters war. Seitens Check Point ist man aktuell noch unsicher, ob man sich nun eine SASE- oder eine SSE-Lösung eingekauft hat: Je nach Quelle ist einmal von SASE und einmal von SSE die Rede. Mit diesen Akronymen tut sich aktuell nicht nur Check Point etwas schwer. Einige Hersteller befinden sich in diesem Namensgebungsdilemma – im Grossen und Ganzen können die beiden Akronyme für die Praxis gleichgestellt werden.

Lasst euch nicht unterkriegen!

Eine Firma, die erst seit 2018 besteht und doch bereits 250 Mitarbeiter und 3000 Kunden zählt, in den «Koloss» namens Check Point zu integrieren, stelle ich mir sehr herausfordernd vor. Seit 2020 hat Check Point mit Perimeter 81, Atmosec, Avanan und Odo Security bereits vier Firmen eingekauft, welche im S(A)SE-Umfeld Produkte entwickelten.

Check Point kauft seit Jahren im Jahresrhythmus eine oder gleich mehrere Firmen ein. Man sollte denken, dass sie mittlerweile eine grosse Erfahrung darin haben, die Produkte, Technologien und insbesondere auch die Schlüsselmitarbeiter zu integrieren. Leider zeigt die Vergangenheit auch, dass nicht alle Einkäufe zum Erfolg wurden. Von so weit aussen ist es schwierig abzuschätzen, wieviel «Odo» noch neben Perimeter 81 existieren wird. Ob sich intern Synergien nutzen lassen oder ob der Kauf von Perimeter 81 die Konsequenz daraus ist, dass die Odo-Lösung nicht konkurrenzfähig war? Wir wissen es nicht. Hoffen wir, dass die Vision, die Ideen und die Energie dieses neuesten Zugangs nicht im Grosskonzern-Groove untergehen.

Das Rennen hat längst begonnen

Die Lösung Perimeter 81 soll innert weniger Stunden bei Kunden produktiv integriert sein und durch ihre Einfachheit überzeugen. Wer Check Point Appliances kennt, der weiss, wie kompliziert und manchmal schon auch ein bisschen träge sich diese konfigurieren lassen. Ich habe Perimeter 81 selbst noch nicht bedient, wäre jedoch dankbar, wenn sich so etwas Einfaches und Schlankes durch die zweifellos hervorragenden Schutzmechanismen von Check Point ergänzen lässt.

Das SASE-Rennen um die Gunst der Kunden ist schon längst gestartet und Check Point hat sich mit diesem neusten Zukauf technologisch in eine gute Position bringen können. Länger zuwarten und die bestehenden Produkte auf dasselbe Niveau zu heben, scheint für Check Point keine Option gewesen zu sein. Ich deute dies als ein Zeichen, dass die eigenen Produkte bisher mehr als nur um ein paar Monate Entwicklungszeit hinter der Konkurrenz zurücklagen. Während des Rennens und aus eigener Kraft, die Zeit gutzumachen, hat sich Check Point nicht zugetraut – zumindest nicht zu denselben Kosten: 500 Millionen hat es sich Check Point kosten lassen.

Ich würde mich freuen, wenn Check Point in diesem Rennen zur Spitzengruppe aufschliessen und es schaffen könnte, ihr etwas angestaubtes Image als (Intel-)Hardware-Firewall-Hersteller endlich abschütteln zu können. Lasst doch mal die jungen Wilden ins Rennen, damit sich die innovativen Zukäufe entfalten können

Weiterführende Links:

www.checkpoint.com/press-releases/check-point-software-completes-acquisition-of-perimeter-81

www.checkpoint.com/quantum/sase

www.avantec.ch/loesungen/check-point

www.tec-bite.ch/cyber-security-ist-teuer-auch-gleich-besser

www.tec-bite.ch/erhoehung-der-cyber-resilience-cybersecurity-vorfaelle-richtig-trainieren

Der Beitrag Make or buy: Wenn die Eigenentwicklung zu lange dauert erschien zuerst auf Tec-Bite.

Cisco Smart Account? Contract ID? Was? – Part 2

Willkommen zurück zu meiner kleinen Blogreihe über die verschiedenen Cisco-Portale. Hier zeige ich die praktischen Webseiten von Cisco auf und auch, wie ihr auf diese Zugriff erhaltet und nutzen könnt.

In meinem letzten Blogartikel habe ich ein paar Portale von Cisco vorgestellt und auch, wie man sich einen Account anlegen und Berechtigungen geben kann.

Das letzte Mal sind wir bei dem Portal software.cisco.com stehengeblieben. Dort habe ich die Verlinkung für das Software-Download-Portal gezeigt. Nun zu weiteren nützlichen Verlinkungen:

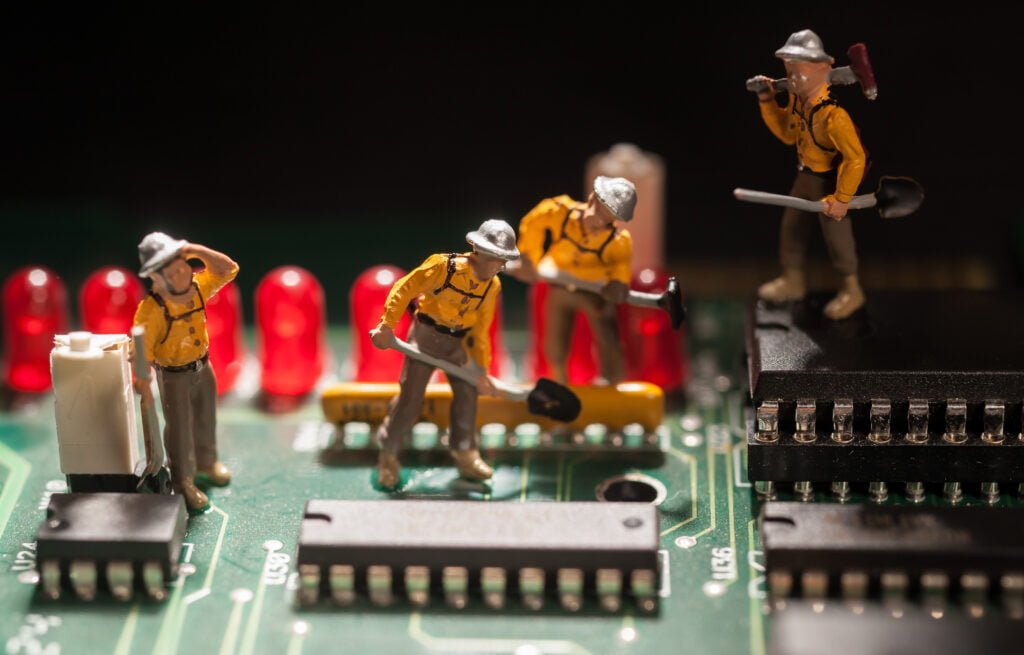

My Notifications

Auf der linken Seite findet ihr die Verlinkung für das Benachrichtigungsportal.

Das Portal für die Benachrichtigungen kann auch direkt über den Link https://cway.cisco.com/mynotifications aufgerufen werden.

Beim ersten Aufruf der Seite wird diese noch recht leer sein. Mittel dem grünen Button «Create Subscription» können persönliche Benachrichtigungen für folgende Themen erstellt werden:

- Cisco Security Advisories

- Field Notices

- End of Sale / Support Announcements

- Software Updates

- Updates for Known Bugs

Die einzelnen Themen sind immer auch anpassbar auf die Produkte, welche man selbst im Einsatz und Gebrauch hat.

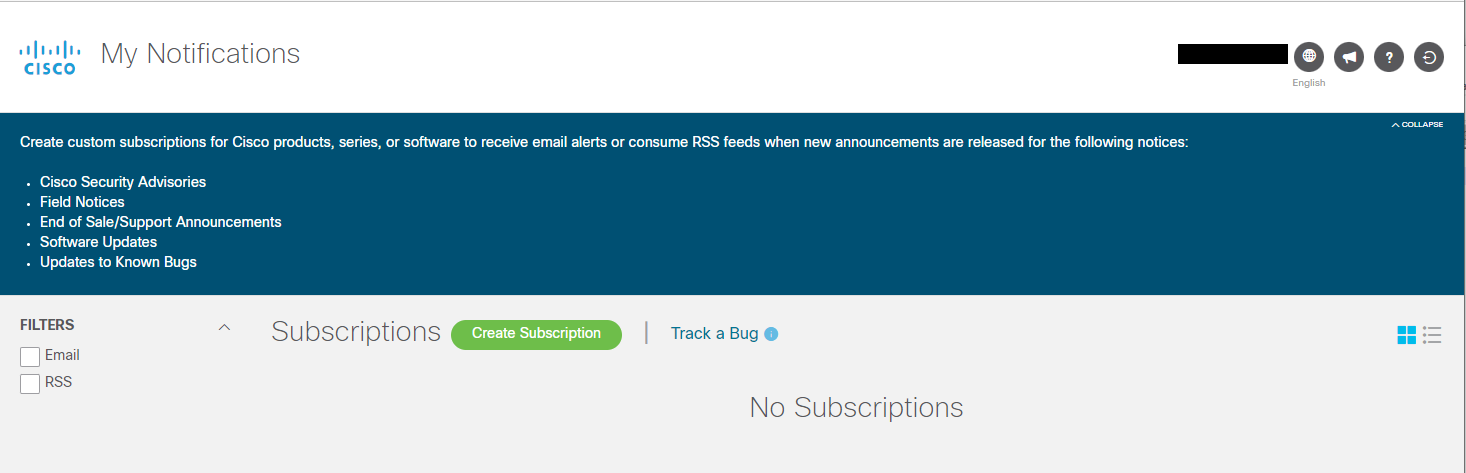

Nach einem Klick auf den grünen Button «Create Subscription» erscheint eine Maske, in welcher man die Benachrichtigung konfigurieren kann.

In dieser Maske kann man nun die gewünschte Benachrichtigung oder auch Subscription erstellen. Zuerst kann ausgewählt werden, ob man diese via Mail oder als RSS Feed empfangen möchte. Weiter können die Häufigkeit, Titel und Empfängeradresse (nur bei E-Mail) angegeben werden.

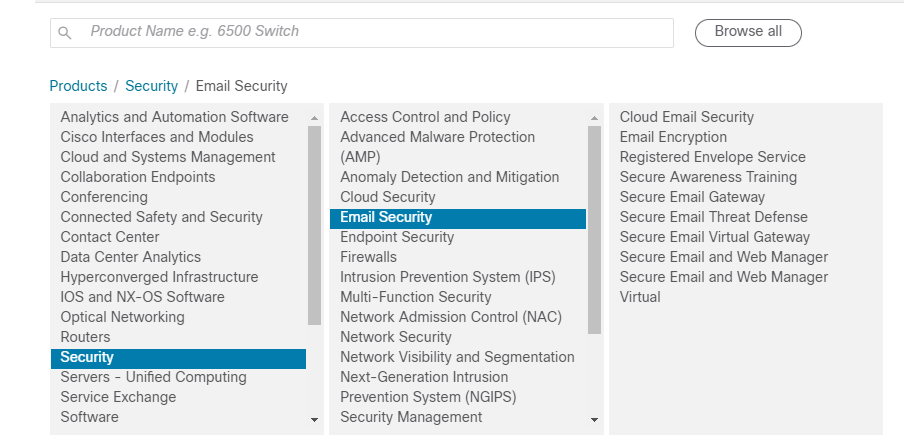

Danach welche Arten von Informationen man erhalten möchte. Diese sind in zwei Unterkategorien unterteilt und es können nicht alle fünf zusammen angewählt werden. Als Beispiel, wenn man für die Cisco E-Mail Security Appliances «AsyncOS Updates» und bekannte Bugs auf dem Laufendem gehalten werden möchte, können diese zusammen ausgewählt werden. Weiter kann unter «Products» die E-Mail Security markiert werden.

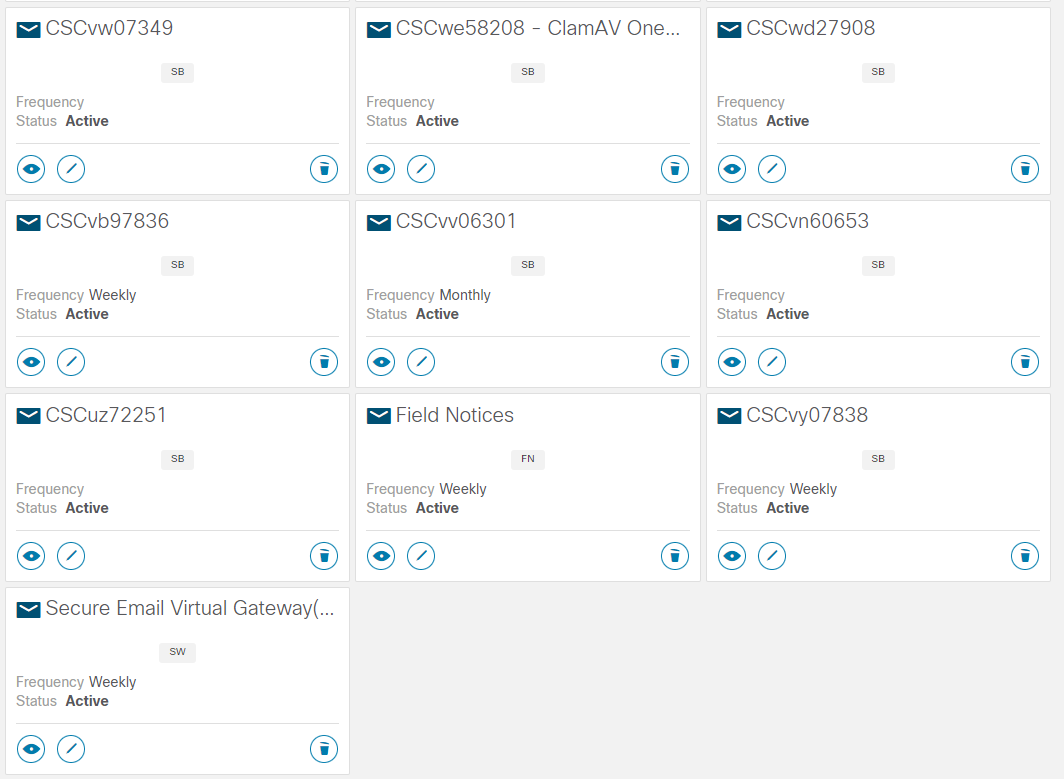

Auch für einzelne Bugs kann jeweils eine Benachrichtigung erstellt werden. Am einfachsten direkt über das Bug Search Tool, welches ich im nächsten Abschnitt zeigen werde. Danach sieht dann die zuerst leere Seite möglicherweise bald so aus:

Hier können die erstellten Benachrichtigungen sowohl administriert als auch, wenn nicht mehr benötigt, gelöscht werden.

Das nächste Portal werdet ihr hoffentlich nie verwenden

Bug Search Tool Portal

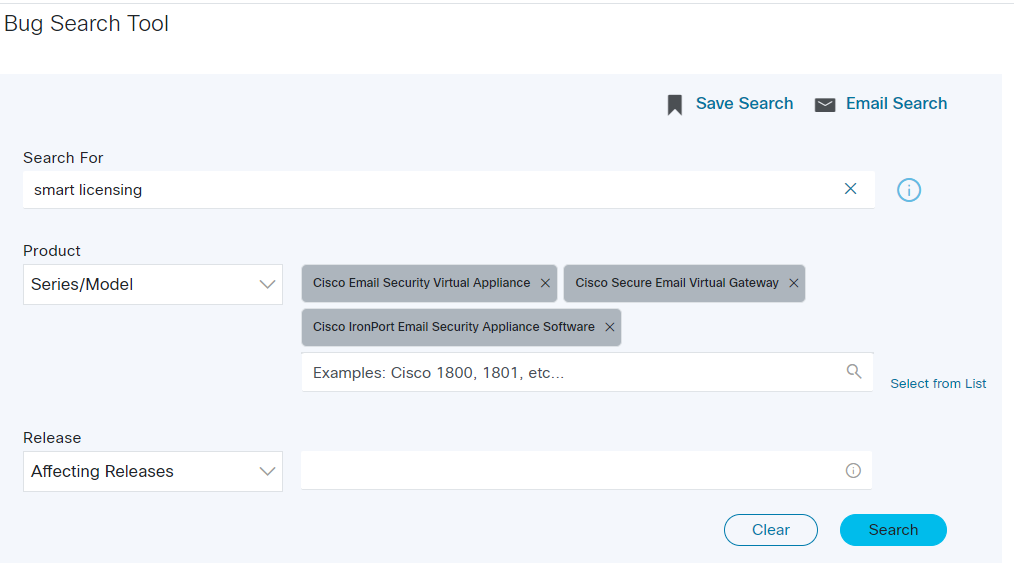

Dieses ist ebenfalls auch auf der Software- and Downloads-Seite und mit einem Klick wird dieses geöffnet. Wie der Name schon verrät, ist es hier möglich, nach bekannten Bugs, Produkten, Versionen oder auch spezifischen Schlüsselwörtern zu suchen.

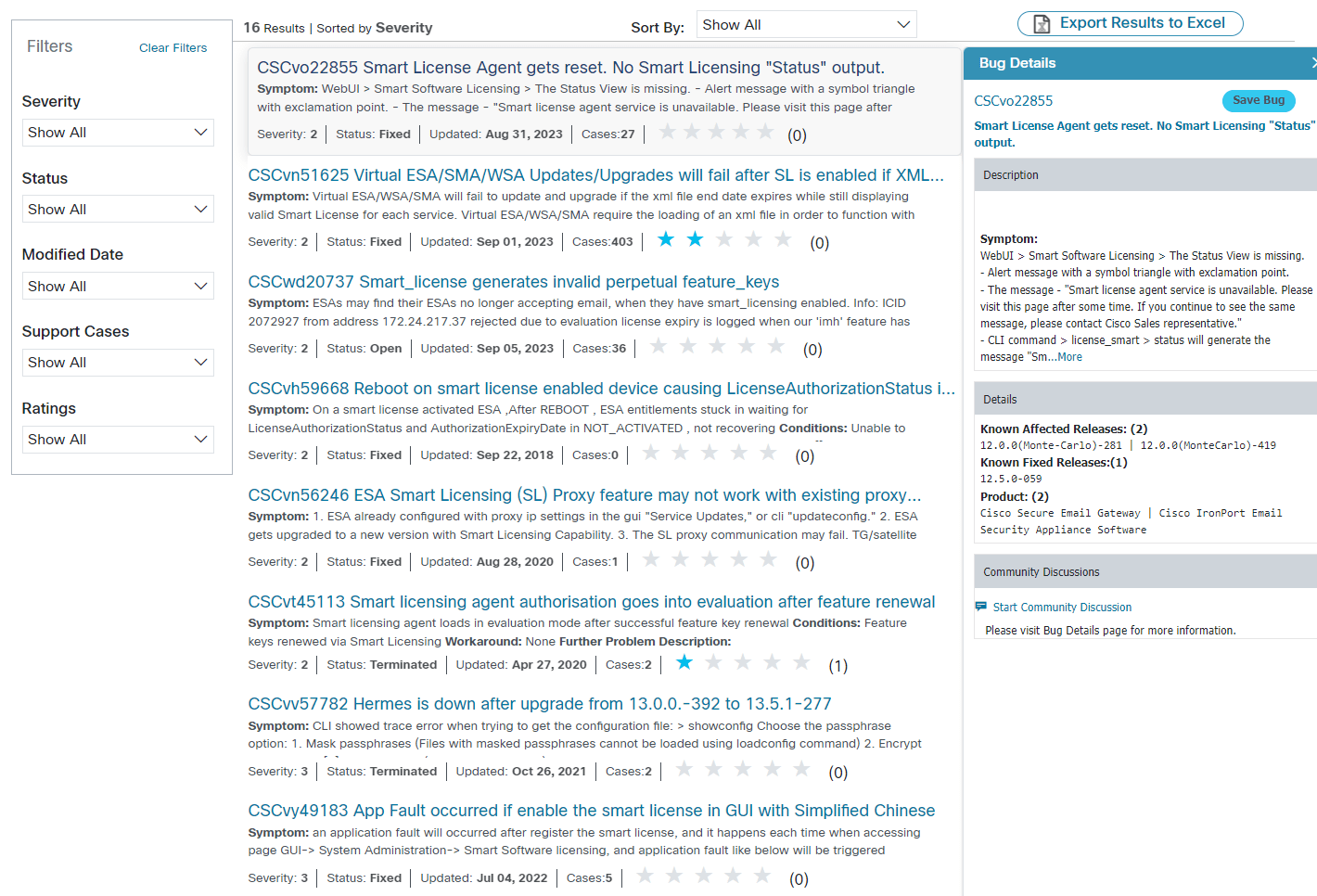

Ich habe hier mal nach «Smart Licensing» für alle ESA Appliances gesucht. Man könnte hier jetzt auch noch nach einer bestimmten AsyncOS-Version suchen, die es betrifft und oder gefixt hat.

Sind bekannte Bugs vorhanden, werden diese unten angezeigt. Bewegt man die Maus über den Titel, erscheint rechts dann die Übersicht und man kann sich sogleich diesen Bug speichern und eine Benachrichtigung einrichten.

Klickt man auf einen Bug, wird dieser dann in einem neuen Tab vollständig angezeigt.

Ein kleiner Tipp noch von mir:

Ich würde nicht immer nach der ganzen Versionsnummer z.B. nach 14.2.0-620, suchen, sondern es ein wenig offenlassen, da nicht immer alle Bugs für jede genaue Version markiert werden.

Weiter jetzt zum nächsten Portal, das sehr wichtig ist:

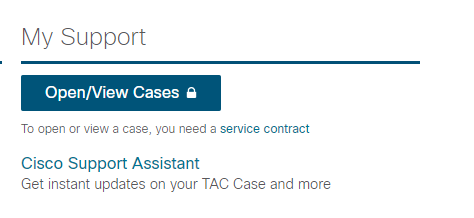

Support Case Manager

Auch hier verrät uns der Namen schon alles

Hier können wir die offenen und geschlossenen Support Cases verwalten, sowie auch neue eröffnen.

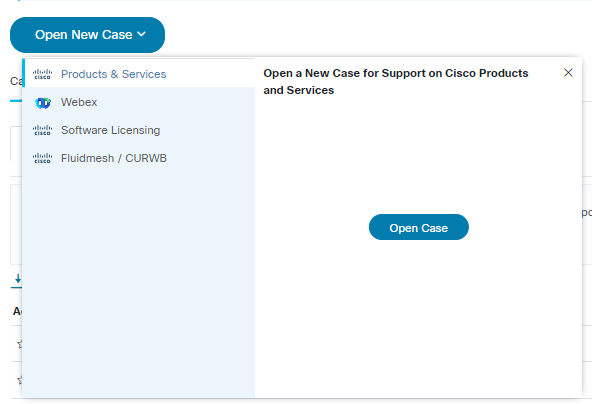

Eröffnen eines Cases

Mittels dem «Open New Case»-Button kann dies bewerkstelligt werden und es werden sogleich verschiedene Optionen angezeigt.

Für Anfragen, Probleme oder Unterstützung kann die erste Option «Products & Services» gewählt werden. Besteht eine Anfrage oder Problem mit Lizenzen: die «Software Licensing»-Option.

Wählt man zu Beginn die falsche Option, ist dies gar kein Problem und man wird dann vom Support zum richtigen Team weitergeleitet; es kostet jedoch ein wenig mehr Zeit.

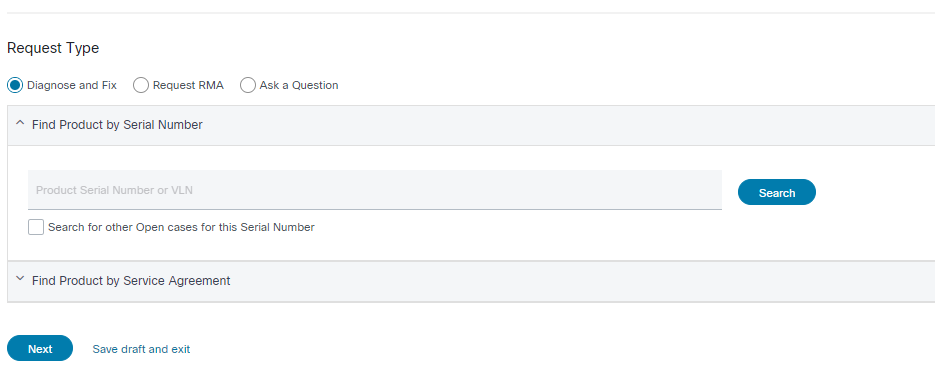

Im ersten Teil kann schon der Anfragetyp angewählt werden und ist wichtig, dass man z.B. gleich zum RMA-Team weitergeleitet wird, da man keine wertvolle Zeit verlieren möchte.

Hat man noch eine Hardware Appliance, kann man sogleich hier mit der Seriennummer suchen.

WICHTIG: Nicht die komplette Seriennummer ins Feld eintragen, sondern nur den zweiten Teil nach dem Bindestrich!

Mit der virtuellen Seriennummer (starten bei der ESA mit VLNESA) kann dies auch funktionieren, diese ist aber nicht immer auffindbar.

Wenn man einen Case für eine virtuelle Appliance eröffnen möchte, empfehle ich, dies mit der zweiten Maske zu erledigen.

Durch das Auswählen der «Find Product by Service Agreement» erscheint eine weitere Maske, in welcher der gewünschte Vertrag gesucht werden kann. Weiter werden auch schon alle verknüpften Verträge unten angezeigt.

Tipp: Findet man den gewünschten Vertrag nicht, kann man diesen mit der Contract ID im Feld «Service Contract» suchen und wenn dieser noch nicht mit dem eigenen Cisco-Account verknüpft ist, dies sogleich auch noch machen 🙂

Wurde der Vertrag ausgewählt, kann man zum nächsten Schritt mit dem «Next» Button wechseln.

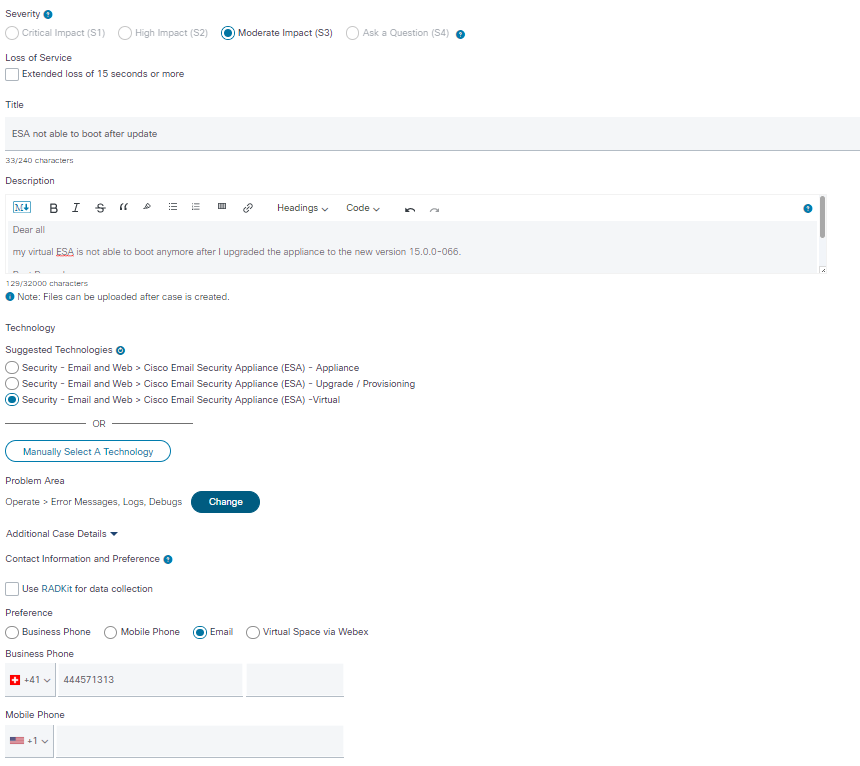

Hier kann nun die Anfrage gestellt werden und es ist immer hilfreich, dem Support so viele Informationen schon im Anfangstext mitzugeben. Dies spart euch und auch dem Support wertvolle Zeit

Nach dem Text können noch der Bereich der Anfrage spezifiziert sowie auch die Kontaktdaten und auch weitere CCs angegeben werden.

Im unteren Teil kann auch schon angegeben werden, wie und wann man am liebsten kontaktiert werden möchte. Den neuen Case kann man dann mit «Submit» erstellen.

Zurück in der Übersicht kann man die Case nun überwachen und filtern. Muss man noch ein File oder einen Kommentar hinzufügen, kann man einfach auf die Case-Nummer klicken und diese von dort aus weiterbearbeiten. Die Kommunikation kann auch via Mail erfolgen, hierbei ist es wichtig, dass man die Case-Nummer im Betreff hat und auch immer im CC attach@cisco.com drin lässt.

Für den letzten Part hab ich mir noch was ganz Spannendes aufgehoben und zwar die Lizenzportale (jup, Mehrzahl).

Dies aber im nächsten Blogartikel

Lasst mich wissen, ob ihr spezifische Fragen hierzu habt – oder auch sonst –, welche Portale ihr schon genutzt habt oder ob ich noch ein wichtiges ausgelassen habe.

Weiterführende Links

Der Beitrag Cisco Smart Account? Contract ID? Was? – Part 2 erschien zuerst auf Tec-Bite.

Die Herausforderungen bei einem SIEM

Die frühzeitige Erkennung von Cyber-Angriffen gehört zu den grundlegenden Aufgaben eines Security Operations Centers (SOC). Viele Unternehmen haben in der Vergangenheit als zentrales Element ein Security Information & Event Management System (SIEM) eingesetzt, welches auf Basis von Log-Daten sowie darauf aufbauenden «Detection Use Cases» Angriffe erkennen soll.

Dieser Ansatz gerät jedoch immer mehr unter Druck, mögliche Gründe sind:

Ungenügende Threat Coverage

- Trotz des teils aufwendigen Use Case Engineerings wird keine zuverlässige Erkennung erreicht.

- Die Transparenz hinsichtlich Abdeckung fehlt oder wird der Dynamik der Bedrohungslandschaft nicht gerecht (z.B. mittels eines dynamischen Mappings auf die Angreifer-Taktiken und -Techniken gemäss MITRE ATT&CK).

- Use Cases, die einmal funktioniert haben, werden nicht regelmässig getestet und funktionieren irgendwann nicht mehr.

Stetig steigende, zu hohe Kosten

- Die klassischen SIEM-Anbieter lizenzieren nach dem Log-Volumen, dies führt zu einer schlechten Planbarkeit und stetig steigenden Kosten.

- Im schlechtesten Fall können sicherheitsrelevante Logs nicht mehr an das SIEM gesendet werden, da die Kosten zu hoch würden.

Zu viele Security Events/False-Positives

- Eine ungenügende Qualität der Use Cases führt zu einer hohen Anzahl an Security Events sowie False-Positives.

- Das SOC Team verwendet wertvolle Zeit bei der manuellen Analyse potenzieller Security Events, die sich im Gesamtkontext als uninteressant herausstellen.

Zusammengefasst könnte man sagen, dass der klassische SIEM-Ansatz mit den immer komplexeren IT-Landschaften und den sich schnell verändernden Bedrohungsszenarien an seine Grenzen stösst.

Anforderungen an eine SIEM-Alternative

Die Problematik wurde von der Security-Industrie zwar erkannt, diese hat aber auch zugleich mit vielen neuen Begriffen wie XDR (eXtended Detection & Response) und eigenen Interpretationen für Verwirrung bei den Anwendern gesorgt.

Bevor man sich auf die Suche nach einer SIEM-Alternative macht, sollte man sich daher zuerst über einige Anforderungen Gedanken machen, folgende Fragestellungen können dabei helfen:

Wo soll die zukünftige Lösung betrieben werden?

- Via Cloud oder On-Premise?

- Gibt es Einschränkungen bezüglich Datenhaltung (im Ausland)?

Wie sieht das Lizenzmodell idealerweise aus?

- Volumenbasiert vs. Endpoint-basiert?

Werden Detection Use Cases bereitgestellt und gepflegt?

- Können bei Bedarf eigene Use Cases erstellt werden?

- Ist die Abdeckung, z.B. gemäss MITRE ATT&CK Framework, jederzeit einsehbar?

Geschlossenes oder offenes Ökosystem?

- Passt mein Security Stack zum Integrations-Ökosystem des Anbieters?

- Sollen eigene Datenquellen angebunden werden können?

Auf welcher Ebene soll die Korrelation stattfinden?

- RAW-Telemetrie vs. Alert-Daten-Korrelation?

Erwarteter Automatisierungsgrad

- Hinsichtlich Korrelation, Investigation und Response?

Eine zentrale Komponente, welche die Anforderungen stark beeinflusst, ist der mittelfristig angestrebte Maturitätsgrad. Einschränkungen, die zu Beginn kaum ins Gewicht fallen, können mit Erhöhung der Maturität zum Problem werden. Es empfiehlt sich, das Zielbild für die nächsten zwei bis drei Jahre bereits mitzuberücksichtigen.

Managed Service oder Aufbau eines eigenen SOC?

Viele Unternehmen setzen im Bereich Cyber Defense auf einen Managed-Service-Partner, da der Aufbau eines eigenen SOC mit 24/7-Bereitschaft in den meisten Fällen wirtschaftlich nicht sinnvoll ist. Der Managed-Service-Partner stellt im Normalfall neben den benötigten Cyber-Security-Experten und Prozessen auch die Detection-Technologie als Teil des Services bereit. Auch wenn die Technologie bei der Wahl des geeigneten Managed-Service-Partners etwas weniger stark im Vordergrund steht, sollten die erwähnten Aspekte genauso sorgfältig geprüft werden.

Suche nach dem richtigen Anbieter?

Sind die Anforderungen, das Betriebsmodell und das mittelfristige Zielbild definiert, kann die Suche nach einem passenden Managed-Service-Partner oder Lösungsanbieter starten. Dabei empfiehlt es sich, auf der geschaffenen Basis eine «Shortlist» von zwei bis drei passender Partner und Anbieter zu erstellen, um sich nicht im «Security-Analytics-Dschungel» zu verirren. Bevor man sich auf Begrifflichkeiten wie XDR, Next-Gen SIEM, SOC-Plattformen usw. zu sehr versteift, ist es wichtig, das Angebot hinsichtlich Service-Umfang (SLA) und Technologie zu verstehen. Anbieter mit einem modularen Aufbau ermöglichen eine Steigerung der Maturität über mehrere Ausbaustufen.

Fazit

Der Security-Analytics-Markt ist aktuell stark im Umbruch. XDR-Anbieter, die vielfach aus dem Endpoint-Detection-and-Response-Bereich (EDR) heraus entstanden sind, ermöglichen die Korrelation mit zusätzlichen Datensourcen aus den Bereichen Identität, Cloud, Netzwerk, Mail, Web und weiteren Domänen. Diese Anbieter erweitern somit die Threat Detection des EDR um sinnvolle Integrationen, meist in einem geschlossenen Ökosystem des Herstellers sowie definierten Technologie-Partnern. Für viele Anwender, speziell im Bereich der mittelständischen Unternehmen, stellt dies eine sehr kosteneffiziente Möglichkeit dar, die Erkennung von Cyber-Bedrohungen zu erweitern. Eine vollständige Ablösung eines SIEM ist zumindest zum aktuellen Zeitpunkt, aber nicht in allen Fällen möglich. Sind die Anforderungen hinsichtlich der zu integrierenden Datensourcen und Korrelation umfangreicher, gibt es moderne Security-Analytics-Plattformen, welche die Vorteile des XDR-Ansatzes, bei welchem das Detection Engineering durch den Anbieter zu grossen Teilen übernommen wird, mit der Flexibilität eines SIEM vereinen. Das AVANTEC Cyber Defense Team evaluiert laufend neue Lösungen und berät Unternehmen bei der Ausgestaltung der Threat Detection. Gerne steht unser Team jederzeit für einen unverbindlichen Austausch zur Verfügung.

Weiterführende Links:

Der Beitrag Die Herausforderungen bei einem SIEM erschien zuerst auf Tec-Bite.

«Angriffe von Einzeltätern sind klar die Minderheit»

Durch eine Meldepflicht für Cyber-Angriffe bei kritischen Infrastrukturen sollen künftig alle Betreiberinnen und Betreiber kritischer Infrastrukturen am Informationsaustausch teilnehmen und so zur Frühwarnung beitragen. Welche Cyber-Angriffe das Nationale Zentrum für Cyber-Sicherheit (NCSC) aktuell besonders auf dem Radar hat und welche Konsequenzen das neue Bundesgesetz über die Informationssicherheit beim Bund nach sich zieht, verrät Max Klaus, stv. Leiter Operative Cyber-Sicherheit des Nationalen Zentrums für Cyber-Sicherheit NCSC.

Herr Klaus, im letzten Jahr ist die Zahl der gemeldeten Cyber-Angriffe beim NCSC wiederum gestiegen (von 22’000) auf rund 34’000 Meldungen. Welche Entwicklung steht dahinter? Beobachtet das NCSC einen besonderen Trend organisierter Gruppen wie staatlicher Akteure und Script Kiddies?

Je nach Angriffsform können die Angriffe ohne grosses Know-how durchgeführt werden. Das gilt insbesondere für die beiden am häufigsten gemeldeten Kategorien «Phishing» und «Betrug». Dennoch ist es so, dass die meisten Angriffe heute durch gut organisierte Gruppierungen durchgeführt werden. Angriffe von Einzeltätern sind klar die Minderheit. Dass immer mehr Cyber-Vorfälle gemeldet werden, führen wir unter anderem auf die immer bessere Sensibilisierung von Bevölkerung und Unternehmen zurück.

Max Klaus ist stellvertretender Leiter Operative Cyber-Sicherheit im Nationalen Zentrum für Cyber-Sicherheit (NCSC). Er verfügt über einen Fachhochschulabschluss in Informatiksicherheit und ist seit 2002 für die Bundesverwaltung tätig.

Was sind aus Sicht des NCSC die gegenwärtig häufigsten Angriffsvektoren (wie etwa Konfigurationsschwachstellen, Insider-Angriffe und kompromittierte Credentials)?

Es gibt zahlreiche mögliche Angriffsvektoren. Nach wie vor werden viele Angriffe nach dem «Giesskannnenprinzip» eingeleitet: Es werden Mails mit schadhaften Anhängen an hunderttausende potenzielle Opfer geschickt. Schliesslich ist auch das «Social Engineering» zu erwähnen. Denn oft gelten Cyber-Angriffe in einer ersten Phase nicht der technischen Infrastruktur, sondern es wird versucht, mittels psychologischer Tricks z. B. Mitarbeitende einer Firma so zu beeinflussen, dass sie etwas tun, was den Angreifern hilft, beispielsweise das Öffnen eines verseuchten E-Mai-Anhangs.

Hochspezialisierte Managed Security Services (SOCs) sind in den letzten Jahren auf dem Cyber-Security-Markt vermehrt im Trend im Kampf gegen dynamische Bedrohungslagen. Wie gut machen aus Ihrer Sicht die IT-Security-Anbieter in dieser Hinsicht ihren Job?

Wie in jeder Branche gibt es wohl auch bei den Managed Security Providern bessere und weniger gute Unternehmen. Die Qualität der Security-Dienstleister können wir nicht abschliessend beurteilen. Wichtig ist in diesem Zusammenhang, dass vor einem allfälligen Vertragsabschluss genau geklärt werden sollte, welche Dienstleitungen tatsächlich erbracht werden müssen.

Je nach Angriffsform können die Angriffe ohne grosses Know-how durchgeführt werden.

Max Klaus, stv. Leiter Operative Cyber-Sicherheit des NCSC

Der Zeitpunkt der geplanten Rede des ukrainischen Präsidenten war im Zuge kürzlicher Angriffe auf zahlreiche Bundes-Websites kein Zufall. Wer war alles betroffen und welche Learnings hinsichtlich der NCSC-Beobachtungslage konnte man aus diesen Incidents herleiten?

Ereignisse mit einer gewissen politischen Brisanz können durchaus zu Aktivitäten im Cyber Space führen. Von den erwähnten DDoS-Angriffen waren zahlreiche Websites der Bundesverwaltung, darunter auch jene des NCSC, betroffen. Die eingeleiteten Gegenmassnahmen zeigten jedoch Wirkung. Neben dem temporären Ausfall zahlreicher Bundes-Websites hatte dieser Angriff keine Folgen für die Bundesverwaltung. Die Analysen und allfälligen Learnings sind in Erarbeitung und werden in einen Bericht einfliessen.

Nach wie vor werden viele Angriffe nach dem «Giesskannnenprinzip» eingeleitet: Es werden Mails mit schadhaften Anhängen an hunderttausende potenzielle Opfer geschickt.

Max Klaus, stv. Leiter Operative Cyber-Sicherheit des NCSC

Betreiber kritischer Infrastrukturen, die bei Cyber-Angriffen mit grossem Schadenspotenzial der neuen Meldepflicht nicht nachkommen, können mit bis zu 100’000 Franken gebüsst werden. Können Sie etwas zum Stand der Dinge sagen?

Der Bundesrat hat 2022 die Einführung einer Meldepflicht für kritische Infrastrukturen beschlossen. Die anschliessende Vernehmlassung zeigte, dass die Wirtschaft einer solchen Meldepflicht positiv gegenübersteht. Allerdings wurde u. a. darauf hingewiesen, dass Meldungen so unbürokratisch wie möglich eingereicht werden sollen. Das Parlament hat vor Kurzem in seiner Schlussabstimmung die Meldepflicht von Cyber-Angriffen für Betreiber kritischer Infrastrukturen gutgeheissen.

Die Gesetzesvorlage zur Meldepflicht verpflichtet nicht nur die Unternehmen zur Mitwirkung beim Schutz vor Cyber-Angriffen, sondern auch das NCSC, den Meldenden beratende Unterstützung bei der Reaktion auf Cyber-Angriffe anzubieten. Von welchen Hauptdienstleistungen profitieren Security Professionals beim NCSC konkret?

Das NCSC stellt den Betreibern kritischer Infrastrukturen ein Portal zu Verfügung. Über dieses Portal werden Informationen über Cyber-Angriffe, Cyber-Bedrohungen, Schwachstellen usw. ausgetauscht. Diese Informationen stammen häufig aus öffentlich nicht zugänglichen Quellen und bieten schon deshalb einen grossen Mehrwert. Ausserdem kann das NCSC auf Wunsch eines betroffenen Unternehmens, wenn möglich auch vor Ort, Empfehlungen über das weitere Vorgehen abgeben. Ein physischer Eingriff in die IT-Infrastruktur des betroffenen Unternehmens ist aber aus verschiedenen Gründen nicht möglich. Die empfohlenen Massnahmen müssen durch die hauseigene IT oder durch ein darauf spezialisiertes Drittunternehmen vorgenommen werden.

Das Nationale Zentrum für Cyber-Sicherheit wird per 1.1.2024 in das Bundesamt für Cyber-Sicherheit überführt. Die NCSC-Kompetenzen, die in den vergangenen Jahren beim Eidgenössischen Finanzdepartement (EDF) untergebracht waren, sind ab dem neuen Jahr dem Departement für Verteidigung, Bevölkerungsschutz und Sport (VBS) angesiedelt.

Weiterführende Links

Der Beitrag «Angriffe von Einzeltätern sind klar die Minderheit» erschien zuerst auf Tec-Bite.

Zusätzliche Zero-Day Protection mit Privilege Management

Im Jahr 2022 wurden für Microsoft Edge 311 Schwachstellen registriert. Wenn solche Schwachstellen noch nicht bekannt sind und ausgenutzt werden, dann nennt man diese Zero-Day Attacks. Wie ein Privilege Management Zero-Day Attacks verhindern kann, möchte ich im Folgenden anhand eines Beispiels von BeyondTrust aufzeigen.

Policy Templates

BeyondTrust liefert mit Privilege Management einige vordefinierte Policy Templates mit. Diese Templates erlauben es, die Policies innert kürzester Zeit firmenweit auszurollen. Mit Privilege Management muss im Unternehmen vor dem Deployment nicht monatelang aufgezeichnet werden, welche Anwendungen eingesetzt werden. Die Policy Templates verkürzen die Implementierungszeit von Privilege Management deutlich. Anstelle von Monaten kann Privilege Management in Wochen ausgerollt werden.

TAP Policy Template

Neben den QuickStart Policy Templates hat der Hersteller auch zwei Trusted Application Policy (kurz «TAP») Templates mitgeliefert. Die beiden Templates bieten den gängigsten Business-Anwendungen wie Microsoft Office, Adobe Reader und den Browsern einen zusätzlichen Schutz. Diese Business-Anwendungen sind natürlich beliebte Angriffsziele. Ganz nach dem Motto: «Je bekannter eine Software, desto grösser die Zielscheibe.» Allein Microsoft Edge hat im letzten Jahr (2022) 311 Schwachstellen verzeichnet. Durch Ausnutzung von Schwachstellen können bei einem Angriffszenario etwa Payloads, Anwendungen oder weitere nicht gewollte Aktionen ausgeführt werden. Genau das unterbindet TAP.

Wie schützt TAP?

Da Privilege Management auf Clients installiert ist, kann es den Start aller Anwendungen kontrollieren: Beispielsweise ob diese geblockt oder sogar mit lokal administrativen Berechtigungen ausgeführt werden sollen. Beim Start einer Anwendung bekommt Privilege Management sehr viele Informationen mit – unter anderem diese Parameter:

- Wer startet die Anwendung oder welcher Parent Process startet eine weitere Anwendung?

- Welche Berechtigungen sollen der Anwendung zugewiesen werden?

- Ist die Anwendung signiert (Herausgeber der Anwendung)?

- etc.

Bei TAP nutzt Privilege Management die Information vom Parent Process. Wenn als Beispiel der Browser eine infizierte Webseite aufruft, kann dadurch eine Schwachstelle im Browser einen PowerShell-Befehl auf dem System ausführen. Da es ungewöhnlich ist, dass der Browser einen solchen Befehl startet, unterbindet TAP von Privilege Management den Start des PowerShell-Befehls. Grundsätzlich sind PowerShell-Befehle erlaubt und Admins können diese absetzen. Aber wenn ein PowerShell-Befehl von einem Browser aus gestartet wird, dann wird der Start durch TAP unterbunden.

Hier ein Video-Beispiel, wie ein JavaScript im Word-Dokument ein PowerShell-Befehl startet, um Payload nachzuladen. Schliesslich werden Die Dokumente auf dem Desktop verschlüsselt:

Aktionsleiste beim Prozess eines Angrifssversuchs ohne TAP

Bei diesem Video unterbindet TAP, dass der PowerShell-Befehl ausgeführt werden kann. Somit wird der Angriff gestoppt und es werden keine Dateien verschlüsselt:

Aktionsleiste beim Prozess eines Angriffsversuchs mit TAP

Fazit

TAP basiert nicht auf einer Datenbank von bekannten Schad-Softwares. TAP unterbindet das Ausführen nicht gewollter Anwendungen, wenn diese von den gängigsten Business-Anwendungen automatisiert gestartet werden. Somit ist TAP ein zusätzlicher und sehr effektiver Schutz, der Zero-Day-Attacken verhindern kann.

Der Beitrag Zusätzliche Zero-Day Protection mit Privilege Management erschien zuerst auf Tec-Bite.

Zscaler Client Connector – Z Tunnel 2.0 vor und nach Version 3.8

Die Zscaler Client Connector Version 3.8? Aber die ist ja schon veraltet und Zscaler hat bereits die Version 4.2.0.198 released. Wieso soll diese nun so spannend sein? Die Zscaler Version 3.8 ist so spannend, weil Zscaler in dieser Version neue Features für die Forwarding-Möglichkeiten bei Zscaler implementiert hat. Es handelt sich dabei um die beiden Funktionen «Redirect Web Traffic to Zscaler Client Connector Listening Proxy» und «Use Z-Tunnel 2.0 for Proxied Web Traffic». Doch was können diese beiden Features und was wird geändert? Genau das wird in diesem Blogeintrag vertieft aufgezeigt.

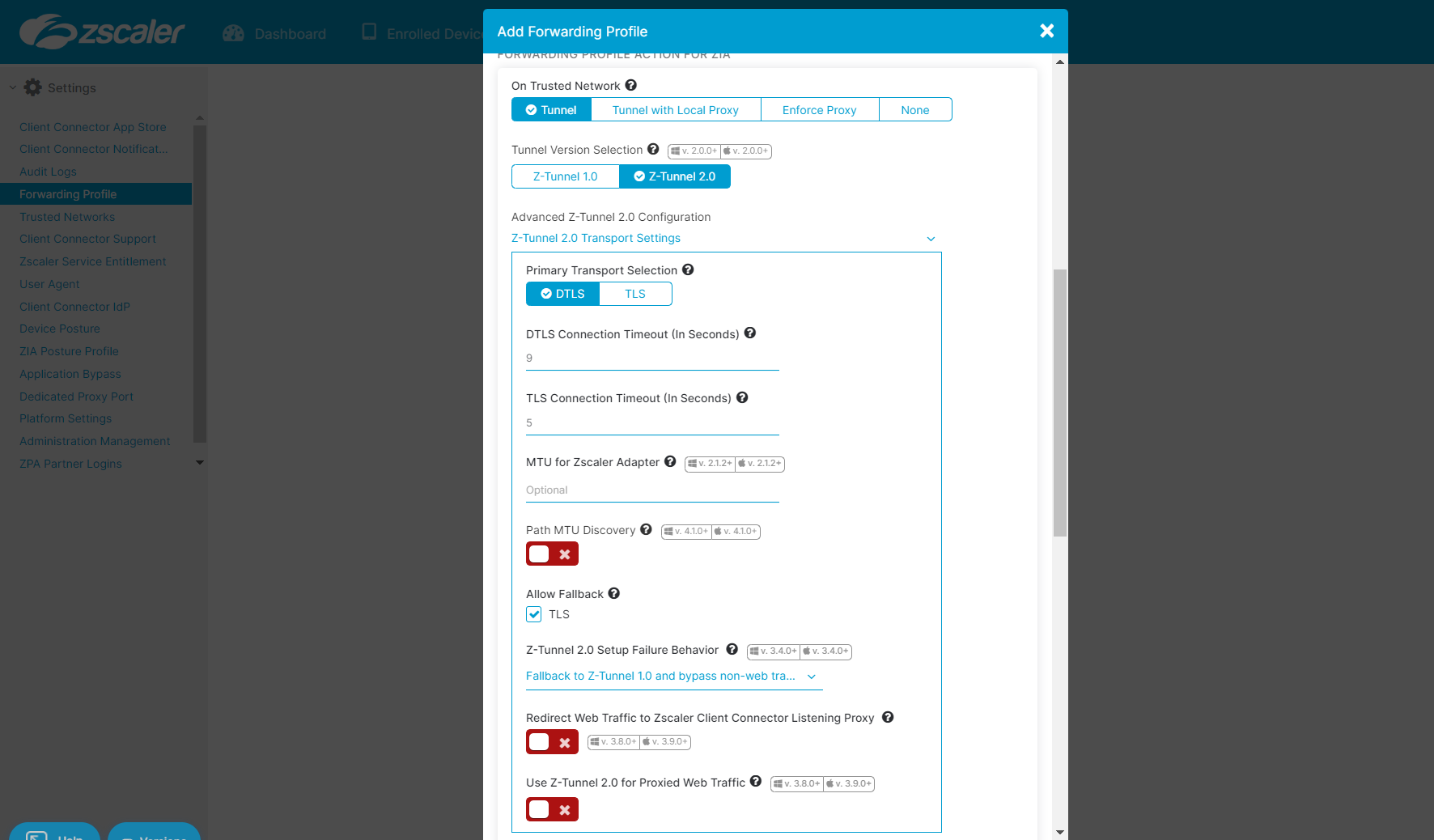

Wo ist das Feature zu finden und was macht es?

Beide Features sind im Zscaler Client Connector GUI unter Administration | Forwarding-Profil im Forwarding-Profil ersichtlich, wenn das Forwarding auf «Tunnel» gestellt und nachdem der «Z-Tunnel 2.0» ausgewählt wurde, im Dropdown-Menü «Z-Tunnel 2.0 Transport Settings» zu finden.

«Redirect Web Traffic to Zscaler Client Connector Listening Proxy» und «Use Z-Tunnel 2.0 for Proxied Web Traffic»

Nachdem nun bekannt ist, wo diese Features eingestellt werden können, widmen wir uns der Beschreibung der beiden Features.

Redirect Web Traffic to Zscaler Client Connector Listening Proxy:

Die Zscaler-Beschreibung dieses Settings beinhaltet, dass bei der Aktivierung dieses Features der gesamte Traffic auf Port 80/443 auf den Zscaler Listening Proxy geforwarded wird.

«Use Z-Tunnel 2.0 for Proxied Web Traffic»: Die Zscaler-Beschreibung dieses Features besagt, dass Traffic auf dem Zscaler Client Connector Listening Proxy via Z-Tunnel 2.0 nach Zscaler gesendet wird. Ansonsten wird dieser Traffic via den Z-Tunnel 1.0 zu Zscaler gesendet.

Nachdem nun die Beschreibung der Features bekannt ist, widmen wir uns deren Funktionalität.

Funktion der beiden Features

Um die Funktionalität der beiden Features verstehen zu können, muss zuerst die Funktionsweise des Forwarding des Zscaler Client Connectors verstanden werden.

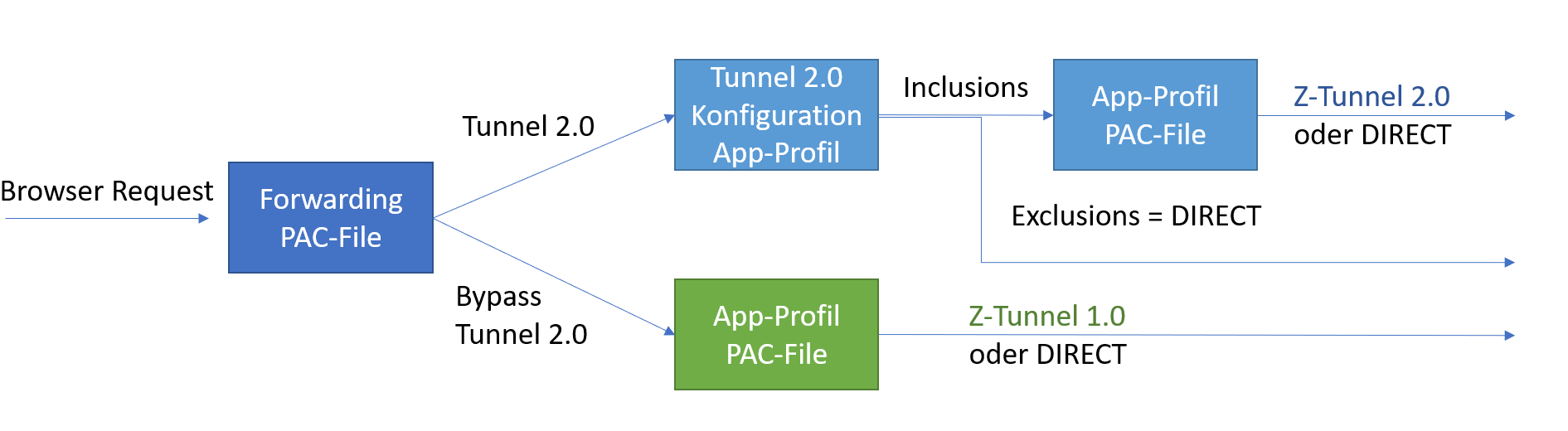

Vor der Zscaler Version 3.8 war die vereinfachte Funktionsweise für das Forwarding wie folgt. Wenn ein Request von einem Browser kam, so wurde als Erstes im Forwarding-Profil überprüft, ob der Tunnel 2.0 «ge-bypasst» werden soll oder nicht. Wenn der Traffic via den Tunnel 2.0 gehen sollte, so wird der Traffic als Nächstes im App-Profil über die Tunnel 2.0 Configuration «Destination Exclusions» und «Destination Inclusions» geprüft. Sofern der Datenverkehr die «Destination Inclusions» matcht, wird der Traffic anhand des App-Profils PAC-File zu Zscaler weitergeleitet.

Wenn der Traffic einen Bypass vom Tunnel 2.0 aufweist, so wird dieser direkt an den Zscaler Client Connector Listening Proxy geforwardet. Danach wird dieser anhand des App-Profils «DIRECT» oder via Z-Tunnel 1.0 zu Zscaler weitergeleitet.

Forwarding ohne die Features «Redirect Web Traffic to Zscaler Client Connector Listening Proxy» und «Use Z-Tunnel 2.0 for Proxied Web Traffic»

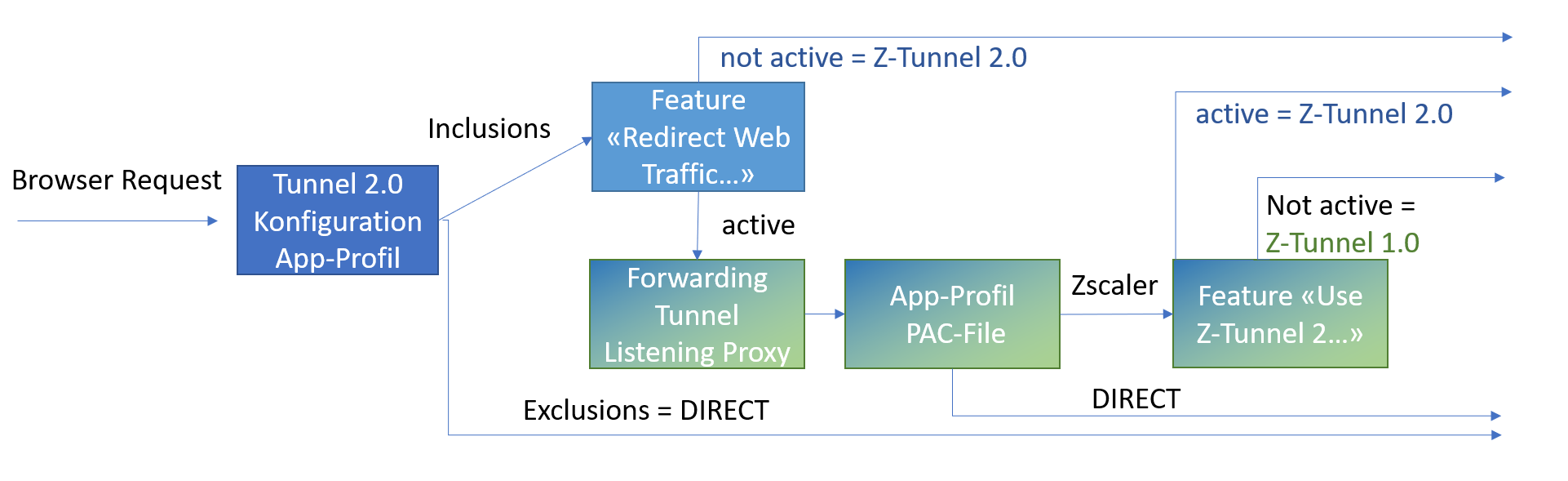

Mit der Version 3.8 kam das neue Forwarding, das vereinfacht, wie folgt funktioniert: Der Traffic wird neu vom Browser direkt anhand der LWF Table, also die Zscaler Z-Tunnel 2.0 Configuration analysiert. Matcht der Traffic die «Destination Inlcusions», kann über das Feature «Redirect Web Traffic to ZCC Listening Proxy» der Web Traffic (gemäss Hilfeseite von Zscaler) auf Port 80 und 443 zu Zscaler weitergeleitet werden. Dieser Traffic wird dann als Nächstes über das App-Profil PAC-File analysiert. Soll gemäss PAC-File der Traffic zu Zscaler gehen, kann mit dem Feature «Use Z-Tunnel 2.0 for Proxied Web Traffic» der Traffic anstatt via Z-Tunnel 1.0 über Z-Tunnel 2.0 zu Zscaler gesendet werden.

Forwarding mit den Features «Redirect Web Traffic to Zscaler Client Connector Listening Proxy» und «Use Z-Tunnel 2.0 for Proxied Web Traffic»

Und was ist nun der Vorteil davon?

Vorteile der beiden Features

Beim Durchlesen der beiden Funktionsweisen fällt auf, dass mit den neuen Settings nur ein PAC-File verwendet wird und das ist das App-Profil PAC-File. Somit vereinfacht sich hierbei die Administratorkonfiguration auf Zscaler-Seite. Weiter können mit den neuen Features wieder Fiddler- / «Charles Proxy»-Mitschnitte erstellt werden. Auch können durch die Verwendung des Z-Tunnel 2.0 mit DTLS in der richtigen Konfiguration Performanceverbesserungen erreicht werden. Eine Ausnahme davon ist, wenn der Provider DTLS Traffic blockiert. Da müsste weiterhin TLS für den Z-Tunnel 2.0 verwendet werden. Wobei auch in dieser Konfiguration mit den neuen Features eine Performanceverbesserung stattfinden kann.

Gibt es auch Nachteile?

Nachteile der beiden Features

Wenn die Features nicht korrekt konfiguriert eingesetzt werden, so kann dies Auswirkungen haben auf die Performance und somit auf die Benutzerzufriedenheit. Ansonsten sind uns aktuell keine Nachteile der beiden Features bekannt.

Was heisst das nun?

Als Erstes: Die alte Konfiguration mit zwei PAC-Files (Forwarding und App-Profil PAC-File) funktioniert auch weiterhin. Also nach der Version 3.8 und ohne die Verwendung der beiden Features. Bei der Verwendung der beiden Features ab der Version 3.8, ist es wichtig die Konfiguration auf die neuen beiden Features auszurichten, sodass keine Nachteile entstehen.

Weiterführende Links:

Der Beitrag Zscaler Client Connector – Z Tunnel 2.0 vor und nach Version 3.8 erschien zuerst auf Tec-Bite.

Wege in eine passwortlose Zukunft – aber woran haperts?

Kompromittierte Kontoinformationen sind eine der Hauptursachen für Datenschutzverletzungen. Deshalb setzen auch grosse Cloud-Anbieter wie Microsoft und Google auf «Passwordless»-Methoden. Die passwortlose Authentifizierung ist ein Mittel zur Überprüfung der Identität eines Nutzers, ohne ein Passwort zu verwenden. Stattdessen werden bei der passwortlosen Authentifizierung sichere Alternativen wie Besitzfaktoren bzw. Hardware-Tokens oder z.B. Mobile Devices verwendet.

Dazu kommt: Immer mehr Unternehmen weiten derzeit ihre digitale Transformation aus und migrieren in die Cloud. Diese Unternehmen stehen vor der Herausforderung, sich mit einer ganzen Reihe neuer Anwendungsfälle befassen zu müssen, beispielsweise mit Sicherheitsverletzungen aufgrund von Identitätsdiebstahl, weil sie bislang unter Umständen nur in einen Authentifizierungsstandard investiert haben.

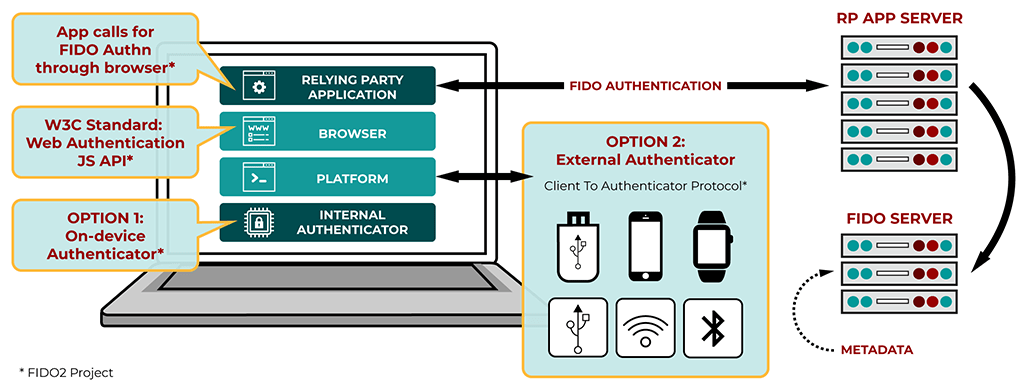

FIDO 2.0 als «Passwordless»-Lösung

Beim Begriff FIDO, der für «Fast Identity Online» steht, handelt es sich um eine Reihe plattformunabhängiger zertifizierter Authenticator Tokens – oder: token on mobile devices –, welche den Benutzeranmeldeprozess für Onlinedienste härten, die auf Kryptografie mit öffentlichen Schlüsseln und elliptischen Kurven basieren. Die Standards werden von der FIDO Alliance entwickelt und fördern schnellere und sichere Authentifizierungsprozesse mit dem übergeordneten Ziel, passwortbasierte Anmeldungen, auch One-Time Passwords, zu eliminieren. Vereinfacht gesagt, handelt es sich um einen Standard, der ohne Zertifikate, jedoch asymmetrisch (via Public Key und Private Key) zur Anwendung gelangt.

Wird FIDO im Zusammenspiel mit einem biometrischen Verfahren bzw. einem zweiten lokalen (und nicht übertragbaren Faktor) wie beispielsweise einem Fingerprint ausgehandelt, handelt es sich dennoch um eine asymmetrische Authentisierung, da die biometrischen Informationen nur lokal als zweiter Faktor verwendet werden, auch wenn das symmetrische Verfahren sind.

In der Cloud, beim IdP, wird jeweils nur der Public Key gespeichert und der Private Key bleibt immer lokal, basierend auf der FIDO-Zertifizierung, geschützt und nicht übertragen. (Nur der sogenannte «Nonce», eine einmalige Zufallszahl in der kryptographischen Kommunikation oder die mit dem Private Key verschlüsselte Version bzw. der verschlüsselte «Hash» geht durch die Leitung.)

Anwendungsszenarien des consumernahen FIDO-Standards

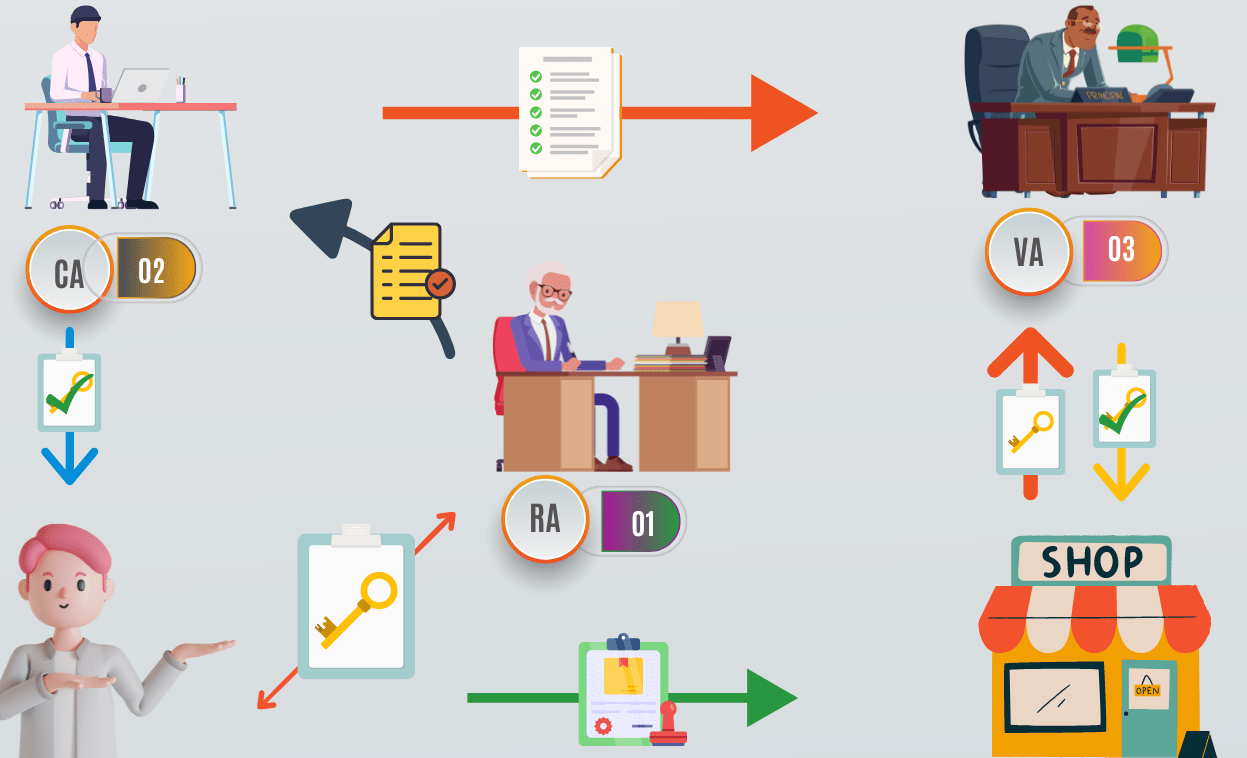

Worin sich PKI und FIDO 2.0 unterscheiden

Die Geschichte von Public Key Cryptography begann bereits in den frühen 1970er-Jahren im Zuge wichtiger Entdeckungen zu Verschlüsselungsalgorithmen beim britischen Geheimdienst. Anders als FIDO 2.0 stützt sich PKI mit den digitalen Zertifikaten auf die Dienste einer vertrauenswürdigen Stelle Certificate Authority (CA), welche den Lifecycle eines kryptographischen Schlüssels mit digitalen Zertifikaten abbildet. Mögliche Anwendungen beinhalten: SSL für Webserver und Webdienste, WLAN- bzw. LAN-Authentifizierung, Smart-Card-Anmeldung, E-Mail-Verschlüsselung, E-Mail-Signaturen und Dokumentensignaturen.

Wie bei FIDO wird bei einer PKI ein Paar kryptographischer Schlüssel (Private and Public Key) verwendet. Das Schlüsselpaar wird beim Requestor erzeugt und die CA signiert die beschreibenden Informationen im Zertifikat mit dem Public Key. Diese digitale Signatur kann von jedem mit dem Public Key der CA verifiziert werden. So ermöglicht diese Hierarchie das Hinterlegen eines CA-Zertifikats, wodurch quasi alle Client-Zertifikate verifiziert werden. Bei FIDO handelt es sich demgegenüber immer um ein «1:1-Mapping».

Schema einer PKI-Architektur

CA: Certification Authority

RA: Registration Authority

VA: Validation Authority

Wo es auf Enterprise-Ebene komplex wird

Die Sicherheitsanforderungen steigen durch eine schnelle Nutzung der Cloud-Infrastrukturen und der Multiplizierung von Endgeräten. Hinsichtlich der Implementierung von PKI bestehen ausserdem Einschränkungen bei Cloud-Anwendungen. So kann PKI-Authentifizierung nicht so leicht auf mobile Geräte angewandt werden. Zudem sind PKI-Szenarien teilweise auf etablierte bzw. Enterprise-Anwendungen via VPN beschränkt.

Wie jedes Sicherheitssystem weist aber auch FIDO einige Nachteile auf. Zwar kann FIDO bei Usecases wie Webadmins oder Fabrikmitarbeitenden Sinn ergeben, da die Anwender unter Umständen kein persönliches Smartphone zur Identifikation mitnehmen möchten. Hier benötigt FIDO keine Zertifikate und man spart sich Kosten und Aufwände; erkauft sich jedoch auch genau jene Nachteile damit. Schliesslich stehen bei Zertifikaten auch Kriterien wie «Validity», «Period» und «Revocation» im Fokus, da ein Zertifikat immer ein Anfangs- und Enddatum beinhalten kann, ab dem es gültig und nicht mehr gültig ist, zumal Enddaten sehr oft anfallen, da die meisten Zertifizierungsstellen es für sinnvoll erachten, ein Zertifikat von Zeit zu Zeit zu erneuern.

So lässt sich nicht nur überprüfen, ob der Inhaber noch echt ist («Trust»), sondern auch ein Zertifikat unter bestimmten Umständen wiederrufen wurde («Revoke»). Dies ist beispielsweise dann erforderlich, wenn der zugehörige private Schlüssel des Inhabers verlorengeht oder die Zertifizierungsstelle dessen Inhaber nicht mehr als vertrauenswürdig erachtet.

Was passiert aber beispielsweise, wenn zu viele Registrierungen mit einem FIDO-Token vorgenommen werden? Was passiert, wenn ein Mitarbeitender sich mit seinem FIDO-Token bei Webservices registriert, die nicht von der Firma vorgesehen sind? Der Nachteil von FIDO liegt daher nicht selten in der Komplexität jener Ausschlussfaktoren begründet, wenn beispielsweise ein Mitarbeitender das Unternehmen verlässt.

Probleme, die sich nur mit einem Identitätsprovider (IdP) lösen lassen

FIDO ermöglicht daher meist nur die Authentifizierung, respektive die sichere Wiedererkennung. Zur Schaffung einer digitalen Identität müssen Authentifizierung und die Identität vom Identitätsanbieter zusammengeführt werden. Hier gelangt ein Identitätsprovider (IdP) zur Anwendung. Da jeder User sich selbst bei allen verwendeten Webservices registrieren muss, ist ein zentraler Authentisierungsdienst (Identity Provider – IdP) notwendig, um den Lifecycle der Token der Mitarbeitenden zu verwalten. Dies umfasst unter anderem die Kriterien:

- Registrierung

- Verwaltung der User-Tokens

(Welcher User verwendet welches Token?) - Validity: Da diese nicht wie bei einem Zertifikat gegeben ist, müssen wir diese für die Mitarbeitenden auf dem IdP realisieren bzw. den Account deaktivieren.

- User-Self-Service: Wie sich Mitarbeitende selbst helfen, damit die User sich online ohne Helpdesk jederzeit neue Credentials zustellen lassen können.

Der IdP verwaltet nebst der Policies für Compliance, Access Control und Re-Authentification vordergründig das Enrollment bzw. die Public Keys des FIDO-Schlüsselpaares. Der Zugriff auf die eigentlichen Webanwendungen erfolgt dann mit Security Assertion Markup Language (SAML) oder OpenID Connect (OIDC). Bei ersterem handelt es sich um eine XML-basierte Auszeichnungssprache bzw. ein Protokoll verschiedener Dienstanbieter wie Office 365, Salesforce und Zoom, während OpenID Connect einer Reihe von (webbasierten, mobilen) Clients den Informationsaustausch über authentifizierte Sessions und Anwender ermöglicht.

Anwendungsszenarien genau evaluieren

Es lohnt sich, die Bedürfnisse im Unternehmen genau zu identifizieren. Sind es beispielweise temporäre Mitarbeitende eines Unternehmens? Werden Cloud- und Webzugriff, FIDO-Badge-Zugriff oder gar eine Hybrid-PKI-FIDO-Lösung benötigt, beispielsweise für digitale Signaturen und Verschlüsselung? Manchmal kann auch exemplarisch eine Smart Card wie IDPrime mit FIDO oder ein eToken Fusion von Thales (ehemals Gemalto) eine Lösung sein, welche sowohl PKI-Szenarien als auch FIDO-Authentifizierung unterstützt und zur physischen Zutrittskontrolle mit RFID wie z.B. kontaktloser Chipkartentechnik nach Legic (in der Schweiz zu 90 Prozent), Mifare Classic & Desfire kompatibel bleibt.

Fazit

FIDO bietet vor allem für mobile Geräte eine hochsichere Passwordless Authentification, die nun seit Anfang 2023 auch in Azure genutzt werden kann. (Certificate-based Authentication mit Zertifikaten einer eigenen PKI sowie Smart-Card-Anmeldung sind dadurch nun auch bei Azure möglich.) So lassen sich grundsätzlich keine Credentials mehr erbeuten. Auch Phishing-Angriffe laufen dann ins Leere. Man fängt sich mit FIDO aber auch ein paar Nachteile ein, da es im Wesentlichen nur um Key-based Authentication für Consumer handelt.

Die Vorteile eines Zertifikats mit Trust, Validity, Revocation und Managed Devices auf Enterprise-Ebene müssen daher bei den Einsatz von FIDO durch einen zentralen IdP kompensiert werden. Das kann Azure sein oder eine Kombination von Card-Management-Systemen sowie eines geeigneten IdP (wie beispielsweise vSEC: CMS & Thales STA). Dort werden die FIDO-Token für die Benutzer im «Send-to-All-Modus» pre-provisioniert und können dann für den Zugriff auf die Unternehmensapplikationen verwendet werden. Die Smart Cards werden wie üblich vollständig vorbereitet und der Enduser bekommt die Karte und die PIN.

Smart Cards decken ein umfassenderes Anwendungsspektrum ab – wie Authentisierung, Signaturen und Verschlüsselungsapplikation. Eine Kombination von allen Möglichkeiten böte aber wohl die grösste Zukunftssicherheit.

Weiterführende Links

Der Beitrag Wege in eine passwortlose Zukunft – aber woran haperts? erschien zuerst auf Tec-Bite.

Neues Datenschutzgesetz – was müssen Firmen wissen?

Unternehmen müssen seit diesem Monat einige verschärfte Regeln im Umgang mit Personendaten beachten. Dreh- und Angelpunkt ist das neue Datenschutzgesetz (nDSG oder revDSG), dessen Bestimmungen seit dem 1. September 2023 gelten. In diesem Artikel erfahrt ihr, was sich geändert hat und wie sich Unternehmen darauf einstellen können.

Warum brauchten wir eine Änderung?

Das alte Datenschutzgesetz aus dem Jahr 1992 war, gemessen an der heutigen Technologiewelt, wie aus der Steinzeit. Seitdem hat sich enorm viel verändert. Als das alte DSG in Kraft trat, wurde das WWW erst gerade erfunden. Das Gesetz war einfach nicht mehr zeitgemäss für Datenkraken, Cloud-Dienste, AI, IoT, Smartphones usw. Aber nicht nur das, die Schweiz stand auch unter Druck, ihre Datenschutzstandards an die EU (DSGVO) anzugleichen, um den freien Datenverkehr mit der EU erhalten zu können.

Die Überarbeitung des DSG hatte vier Hauptziele:

- Mehr Transparenz: Unternehmen müssen jetzt darüber informieren, wie sie persönliche Daten verarbeiten und den betroffenen Personen mehr Kontrolle über ihre Daten geben.

- Förderung von Prävention und Eigenverantwortung: Die revidierten Bestimmungen ermutigen Datenverarbeiter, proaktiv Schutzmassnahmen zu ergreifen und sicherzustellen, dass sie die Datenschutzvorschriften einhalten.

- Stärkung der Datenschutzaufsicht: Die Überwachung der Einhaltung der Datenschutzbestimmungen durch den Eidgenössischen Datenschutz- und Öffentlichkeitsbeauftragten (EDÖB) wird verstärkt.

- Verschärfung der Strafen: Die Strafen für Verstösse gegen das Datenschutzgesetz wurden verschärft und es wurden neue Strafbestände geschaffen.

Die wichtigsten Änderungen im Überblick

Lasst uns einen Blick auf die wichtigsten Änderungen werfen:

- Juristische Personen sind nicht mehr geschützt: Das neue DSG schützt nur noch natürliche Personen. Unternehmen können sich nicht mehr auf das Gesetz berufen und müssen sich stattdessen auf das Firmenrecht und andere bestehende Gesetze verlassen.

- Besonders schützenswerte Personendaten: Die Liste der besonders schützenswerten Personendaten wurde erweitert, um auch genetische und biometrische Daten einzuschliessen. Dies hat Auswirkungen auf die Einwilligung, Datenschutz-Folgenabschätzungen und die Weitergabe von Daten an Dritte.

- Profiling und Profiling mit hohem Risiko: Profiling ist die automatisierte Bewertung von persönlichen Aspekten einer Person. Wenn es ein hohes Risiko birgt, muss die betroffene Person ausdrücklich zustimmen.

- Auftragsbearbeiter: Unternehmen, die Daten auslagern, müssen (wie bislang) sicherstellen, dass ihre Auftragsbearbeiter die Datensicherheit gewährleisten können. Die Übertragung an Unterauftragnehmer erfordert die Genehmigung des Verantwortlichen.

- Datenschutz durch Technik und datenschutzfreundliche Einstellungen: Unternehmen müssen von Anfang an sicherstellen, dass die Datenschutzvorschriften eingehalten werden (Privacy by Design). Die Standardeinstellungen müssen so eingestellt sein, dass die Datenverarbeitung auf ein Minimum beschränkt ist (Privacy by Default).

- Neue Informationspflichten: Unternehmen müssen betroffene Personen über die Identität des Verantwortlichen, den Verarbeitungszweck und weitere Informationen informieren, insbesondere wenn Daten ins Ausland übertragen werden. Gemäss dem bislang geltenden DSG genügte die Erkennbarkeit der Bearbeitung von Personendaten.

- Ausbau der Auskunftspflichten: Betroffene Personen haben das Recht, alle Informationen zu erhalten, die sie für die Geltendmachung ihrer Datenschutzrechte nach dem revidierten DSG benötigen.

- Recht auf Datenübertragbarkeit: Betroffene Personen können die Herausgabe ihrer Personendaten oder deren Übertragung an einen anderen Verantwortlichen in maschinenlesbarer Form verlangen.

- Automatisierte Einzelfallentscheidungen: Personen müssen über Entscheidungen informiert werden, die ausschliesslich auf automatisierter Verarbeitung beruhen und erhebliche Auswirkungen auf sie haben. Sie haben das Recht, diese Entscheidungen überprüfen zu lassen.

- Datenschutz-Folgenabschätzung: Unternehmen müssen eine Datenschutz-Folgenabschätzung durchführen, wenn die Datenverarbeitung ein hohes Risiko für die Rechte und Freiheiten betroffener Personen darstellen kann.

- Meldung von Datenschutzverletzungen: Bei Datenschutzverletzungen müssen Unternehmen diese dem EDÖB und unter bestimmten Umständen auch den betroffenen Personen melden.

- Sanktionen: Das revidierte DSG sieht Geldstrafen bis zu 250’000 Franken für natürliche Personen vor, die vorsätzlich gegen die Datenschutzbestimmungen verstossen. Unternehmen und verantwortliche Personen können nun direkt sanktioniert werden. Im Gegensatz dazu, sind im DSGVO Bussen nur für Unternehmen vorgesehen. Dafür können Bussen aber bis zu 4 Prozent des gesamten weltweit erzielten Umsatzes betragen. Im Fall der UBS wären das ca. 300 Millionen US-Dollar.

Was Unternehmen jetzt tun sollten

Falls noch nicht bereits geschehen, sollte eine Bestandsaufnahme der Datenverarbeitungen durchgeführt werden. Dies sollte im Rahmen einer Gap-Analyse geschehen, um den Handlungsbedarf im Bereich Datenschutz zu ermitteln. Es ist wichtig zu beachten, dass die Datenschutz-Compliance ein kontinuierlicher Prozess ist und keine einmalige Aufgabe. Unternehmen sollten einen Monitoring- und Review-Prozess implementieren, um auf Veränderungen in ihren Datenverarbeitungspraktiken reagieren zu können.

Darüber hinaus ist es entscheidend, Mitarbeiter auf Datenschutzfragen zu sensibilisieren und zu schulen. Dies stellt sicher, dass sie sich keiner persönlichen Strafbarkeit aussetzen und das Unternehmen nicht Gefahr läuft, Sanktionen oder Reputationsschäden zu erleiden.

Nach einer Empfehlung gefragt, empfiehlt Martin Steiger, Anwalt für Recht im digitalen Raum, das Datenschutz-Management auf die Vermeidung eigener Risiken auszurichten. Wer Datenschutz so lebt, dass die Wahrscheinlichkeit für Sanktionen oder Reputationsschäden gering ist, schützt automatisch die betroffenen Personen vor Datenschutzverletzungen. Ärger mit Behörden und betroffenen Personen provozieren Unternehmen meist selbst, beispielsweise durch Datenpannen oder wenn Auskunftsbegehren nicht schnell und vollständig genug beantwortet werden.

Insgesamt bringt das revidierte Schweizer Datenschutzgesetz wichtige Änderungen mit sich, die Unternehmen beachten müssen, um die Einhaltung der Datenschutzbestimmungen sicherzustellen und mögliche rechtliche Konsequenzen zu vermeiden.

Weiterführende Links:

Der Beitrag Neues Datenschutzgesetz – was müssen Firmen wissen? erschien zuerst auf Tec-Bite.